Il Peccato originale e cacciata dal Paradiso terrestre è un affresco di Michelangelo Buonarroti, dipinto attorno all’anno 1510 nella volta della Cappella Sistina, nei Musei Vaticani a Roma,

Nella Genesi biblica c’è un passo che reputo molto significativo: la cacciata dal Paradiso.

Eva, la figura mitologica della prima donna, spinta dalla’incarnazione del Male inteso come l’opposto del Divino, suggerì al suo compagno Adamo ad assaggiare il Frutto Proibito colto dall’Albero della Conoscenza. Fu allora che la coppia primigenia si accorse di essere nuda di fronte alla vastità del Paradiso e venne cacciata.

Amo pensare che il Frutto dell’Albero della Conoscenza sia l’allegoria della Curiosità. E come una di quelle varietà più piccanti di peperoncino che spinge i loro consumatori a ingerire liquidi nel vano sforzo di arginare il disagio, la Curiosità anima la sete di conoscenza che da sempre ci distingue dalle altre specie animali. In questa mia personale interpretazione il Peccato Originale non è altro che l’essenza del Frutto Proibito che si tramanda a tutte le generazioni del genere umano, così come la nudità della Cacciata dal Paradiso la vedo come la rivelazione dell’ignoranza dell’Uomo verso tutto ciò che lo circonda.

L’unico mantello che possa coprire l’umanità consiste nel placare la sua innata sete di conoscenza [1. Ovviamente la mia è solo una libera e personale interpretazione del mito, ma trovo che sia una chiave di lettura che merita attenzione e approfondimento.] e questo blog lo si può interpretare come il tentativo di espiare la mia parte di Peccato Originale.

Per i cristiani e gli ebrei il Libro della Genesi spiega come sia stato creato l’Universo e la Vita. Un passo particolare descrive la creazione dell’Uomo: « Allora il Signore Dio plasmò l’uomo con polvere del suolo e soffiò nelle sue narici un alito di vita e l’uomo divenne un essere vivente. » (Genesi 2,7)

La generazione spontanea

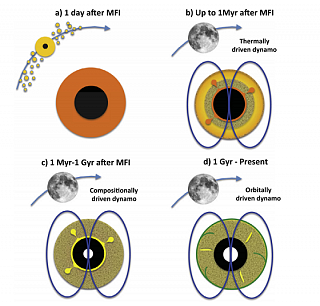

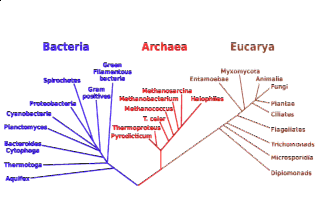

Cavalier-Smith propone solo due grandi domini tassonomici: Eukaryota e Prokaryota. Il dominio prokaryota in realtà è l’unione dei due domini precedenti, che ora diventano regni, Bacteria e Archaea. Questo diagramma mostra i principali tipi di cellula del mondo vivente e la loro probabile evoluzione partendo da organismi ancestrali comuni. Credit: Cavalier-Smith, 2004

Questo è un chiaro esempio di come nell’antichità si cercasse di spiegare come sia sorta la Vita. Oggi parleremmo di abiogenesi (dal greco a-bio-genesis, “origini non biologiche”), ma esso non è un concetto moderno, bensì è antico quasi quanto l’uomo. Le culture abramitiche convergevano nell’indicare sia l’Uomo che tutti gli altri esseri superiori (cani, cavalli, uccelli ad esempio) fossero stati creati per intervento divino, mentre quelli inferiori (mosche, cimici, blatte etc.) traessero origine dallo sporco e dal sudore. Anche nell’antica Cina esistevano credenze analoghe, così come anche nella cultura babilonese, da cui discendono appunto le moderne religioni monoteiste.

Nel pensiero classico greco la vita era direttamente collegata alla materia. Essa appariva spontaneamente qualora le condizioni ambientali le fossero favorevoli, un pensiero che in astratto è molto più moderno di quanto di primo acchito si creda, come vedremo più avanti. Aperti sostenitori della teoria della generazione spontanea furono filosofi del calibro di Talete, Democrito ed Epicuro, ma fu Aristotele che ne fece una sintesi accurata che sopravvisse fin dopo il Rinascimento. Egli sosteneva che gli esseri viventi nascessero da altri organismi simili ma che talvolta avrebbero potuto anche generarsi spontaneamente dalla materia inerte 1. Perfino pensatori famosi come Newton, Cartesio e Bacone sostenevano l’idea della generazione spontanea della vita.

Però la rivoluzione del pensiero scientifico introdotta da Galileo Galilei non mancò di influenzare anche la biologia. L’aretino Francesco Redi fu uno dei primi naturalisti a sperimentare, e a confutare, la generazione spontanea della vita. Egli contestò l’idea che i vermi sorgessero spontaneamente dalla carne putrefatta. Ben conscio che le sue scoperte minavano la posizione aristotelica della Chiesa, Redi fu molto cauto nel divulgare le sue scoperte; quindi fece in modo che le sue interpretazioni fossero sempre basate su passi biblici, come ad esempio il famoso adagio: “Omne vivum ex vivo” (Tutta la vita viene dalla vita).

Il naturalista aretino non fu il solo, nei decenni successivi molti altri scienziati arrivarono alle stesse conclusioni dimostrando come il calore potesse rendere sterile una coltura. In questo campo furono importanti le ricerche del gesuita Lazzaro Spallanzani 2 nel 1757 e di Theodor Schwann nel 1836.

Nonostante tutto erano ancora molti i naturalisti ancora convinti della generazione spontanea della vita. Ma nel 1864 un esperimento del francese Louis Pasteur pose definitivamente fine all’antica visione. Egli sterilizzò un brodo di carne dentro una beuta col collo piegato prima verso il basso e poi verso l’alto senza chiuderlo. In questo modo l’aria sarebbe potuta entrare nel recipiente senza alcun ostacolo tranne che per le impurità dell’aria che si sarebbero depositate sul fondo della curva del collo della beuta; se l’aria effettivamente conteneva un qualsiasi calore vitale questo avrebbe contaminato il brodo. Invece la coltura non produsse microorganismi né altre forme di vita. Ma quando Pasteur ebbe rotto il collo della beuta i germi ricomparvero subito nel brodo.

Fu così dimostrato definitivamente che in assenza di contaminazione da parte di altra materia biologica non poteva esserci una generazione spontanea della vita come fino ad allora si era inteso; il concetto di generazione spontanea era sbagliato, semmai si doveva parlare di riproduzione spontanea. Il motto di Francesco Redi era salvo.

Il moderno concetto di abiogenesi

Zoonomia, Or, The Laws of Organic Life, in three parts (Erasmus Darwin, 1803)

« Would it be too bold to imagine that, in the great length of time since the earth began to exist, perhaps millions of ages before the commencement of the history of mankind would it be too bold to imagine that all warm-blooded animals have arisen from one living filament, which the great First Cause endued with animality, with the power of acquiring new parts, attended with new propensities, directed by irritations, sensations, volitions and associations, and thus possessing the faculty of continuing to improve by its own inherent activity, and of delivering down these improvements by generation to its posterity, world without end! »

« Sarebbe osare troppo immaginare che, nel lungo periodo di tempo da quando la terra ha cominciato la sua esistenza, forse milioni di secoli prima dell’inizio della storia dell’umanità, che tutti gli animali a sangue caldo siano cresciuti da un singolo filamento vivente, che la grande Causa Prima indusse alla vita, con la possibilità di acquisire nuove parti, migliorato da nuove propensioni, guidato da nuovi stimoli, sensazioni, volontà ed associazioni, e per cui capaci di continuare a migliorare per propria attività naturale, e di consegnare questi miglioramenti attraverso la riproduzione alla propria prole, ed al mondo, senza fine! »

Tutto mostrava che la vita potesse originarsi soltanto da altra vita, o come suggeriva Charles Darwin, da forme di vita più semplici preesistenti.

Charles Darwin, naturalista e geologo britannico, scrisse il suo più celebre saggio “L’origine delle specie” nel 1859, partendo dalle riflessioni e gli appunti di viaggio racccolti nei suoi celebri viaggi attorno al mondo col brigantino Beagle, che già erano apparsi in altri lavori minori del celebre scienziato.

Anche se è indubbiamente giusto ricordare Charles Darwin come il padre della teoria sull’evoluzione delle specie, è altrettanto opportuno ricordare l’humus culturale della sua formazione. Suo nonno, Erasmus Darwin, nel 1794 scrisse Zoonomia, un trattato di medicina che in sé suggeriva già alcune idee sulle teorie evolutive che poi sarebbero state fonte di ispirazione per il naturalista francese Jean-Baptiste de Lamarck. Il lamarckismo 3 è probabilmente la prima teoria evolutiva coerente, anche se oggi ampiamente confutata dalle esperienze scientifiche e di laboratorio, in cui si cerca di superare il concetto di immutabilità delle specie come era raccontato dai filosofi greci e dalla Bibbia.

L’idea di una primigenia forma di vita molto semplice riapre il dibattito su chi o cosa ci sia stato prima. Un po’ come il paradosso dell’uovo e della gallina. Chi è nato prima? Per il misticismo religioso non ci sono dubbi: è tutto merito del divino del credo di appartenenza, per gli scettici qualcos’altro.

È così che l’abiogenesi, data per confutata dagli esperimenti di Pasteur, torna prepotentemente in auge col darwinismo per cercare di rispondere a cosa ci sia stato prima delle prime forme di vita.

Oggi ci riferiamo a questo organismo estremamente semplice chiamandolo LUCA (Last Universal Common Ancestor), un antenato comune a tutti i regni (eucaryota e prokaryota) e domini [cite]http://www.ncbi.nlm.nih.gov/pubmed/15306349[/cite] e quindi comune a tutte le forme di vita esistenti sulla Terra. Il riferimento a questo essere animato è fin troppo evidente nel pensiero di Erasmus Darwin. Ma anche LUCA deve essere venuto da qualche parte, ci devono essere stato qualcos’altro prima di lui, qualcosa che prima era inanimato e che poi è diventato vita.

Possiamo attenderci che una serie di eventi chimici ed energetici abbia coinvolto atomi e molecole combinandoli poi in molecole via via più complesse finché esse non sono state in grado di autoreplicarsi 4 [cite]http://dx.doi.org/10.1063/1.4818538[/cite].

Anche la discussione tra origine autoctona o panspermia lascia sostanzialmente invariata la risposta, decidere se le molecole prebiotiche si siano sviluppate qui sulla Terra o se sono piovute dallo spazio grazie alle comete [cite]http://ilpoliedrico.com/2016/05/alla-ricerca-delle-origini-della-vita.html[/cite]. È come se di fronte a una sala superbamente arredata ci si chiedesse se l’arredatore abbia da sé abbattuto gli alberi e costruito i mobili o abbia usato le tavole dell’Ikea.

Il progenote

Questo diagramma, sviluppato studiando l’rRNA comune a quasi tutti gli organismi del pianeta, mostra come i tre domini vita Archea, Bacteria e Eucaryota, siano in realtà imparentati fra loro tramite un ultimo antenato comune universale (il tronco nero nella parte inferiore della struttura). Si noti che la maggior parte dei modelli moderni ora pongono l’origine degli eucarioti all’interno della stirpe archaea. Credit: Wikimedia, CC BY-SA

All’incirca negli ultimi 30 anni sono stati compiuti grandi passi nello studio delle sequenze genetiche. Tale successo ha permesso di identificare e studiare sequenze genetiche comuni alla maggior parte delle specie viventi. Questo è risultato essere molto importante per capire i processi evolutivi di interi gruppi etnici e le loro secolari migrazioni (vedi ad esempio gli Etruschi), ma anche a livello di interspecie, proprio appunto per creare un quadro evolutivo coerente della vita sulla Terra. Lo studio tassonomico di sequenze comuni tra le diverse specie, dai batteri all’uomo per intenderci, ha permesso di scrivere alberi filogenetici come questo qui accanto.

L’analisi di oltre 6 milioni di geni codificanti proteine nel RNA ribosomiale 5 [cite]http://dx.doi.org/10.1038/nmicrobiol.2016.116[/cite], o rRNA, di organismi procariotici ha permesso di isolare un gruppo comune di proteine (355 su 286514, un po’ più dello 0,12%) che potrebbero aiutare a capire l’ambiente ancestrale in cui il progenote deve aver vissuto.

Il mondo di questi organismi ancestrali comuni vissuti quasi tre miliardi e mezzo di anni fa [cite]http://ilpoliedrico.com/2015/01/sedimenti-naturali-e-strutture-fossili.html[/cite] era assai diverso dal nostro. Ancora non esisteva l’atmosfera attuale così ricca di ossigeno [cite]http://ilpoliedrico.com/2010/07/lantica-storia-della-terra.html[/cite] come la conosciamo e da cui quasi tutti gli organismi pluricellulari attuali dipendono, Secondo le proteine sintetizzate dalla componente genetica comune l’ambiente più adatto al progenote era molto simile agli odierni camini idrotermali delle dorsali oceaniche [cite]http://ilpoliedrico.com/2010/07/ce-vita-anche-laggiu.html[/cite]

Questo antenato comune avrebbe metabolizzato idrogeno, usato il biossido di carbonio e di azoto per replicarsi e il ferro come agente catalizzatore negli enzimi cellulari più o meno come ancora oggi fanno molti microbi termofili anaerobici come l’attuale Clostridium thermoaceticum [cite]https://www.ncbi.nlm.nih.gov/pubmed/1900793[/cite].

Al di là quindi delle origini delle molecole organiche complesse, la vita pare essersi sviluppata in maniera autonoma su questo pianeta e in ambienti molto lontani dalla sola energia solare e da quella parossistica dell’atmosfera. Questa scoperta suggerisce che dopotutto anche mondi posti all’esterno di una zona Goldilocks, come ad esempio i satelliti più grandi dei pianeti esterni, potrebbero dare origine a processi biologici importanti e ospitare forme di vita elementare se fossero sede di fenomeni geotermali persistenti.

Niente fulmini, ma il lento cullar del respiro della terra che incontra il mare.