All’inizio ero piuttosto scettico di parlare di 3I/ATLAS. Non perché non fosse interessante, ma per non aggiungermi al coro delle banalità scritte un po’ ovunque su questa cometa. Ma poi, di fronte alle tante corbellerie da Fine del Mondo che ho letto, mi sono deciso a scrivere anche la mia. Magari anch’essa una corbelleria, ma senz’altro più esotica e affascinante.

\(Ni\left( CO \right)_{4}\): la firma chimica di un viaggiatore interstellare

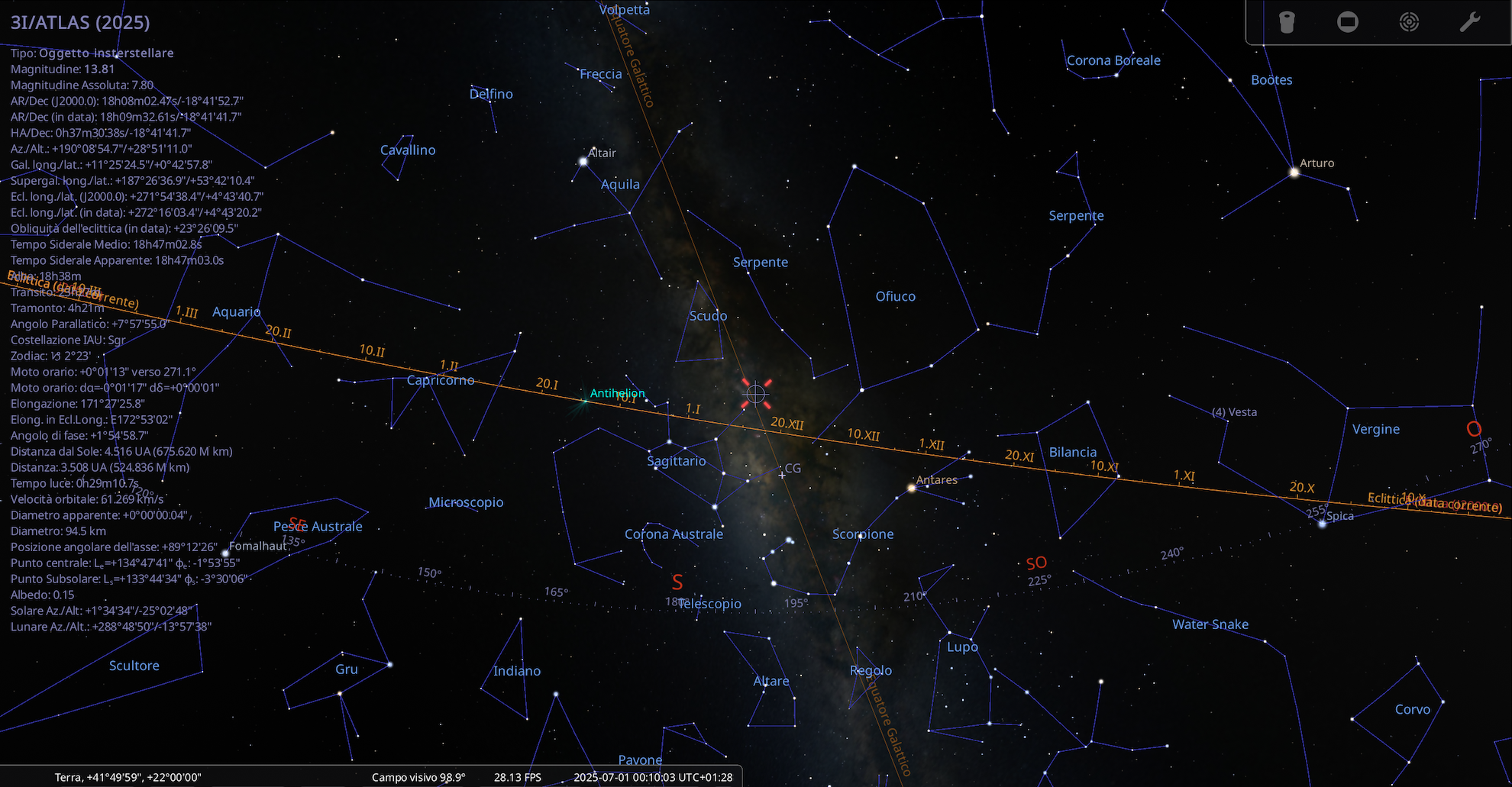

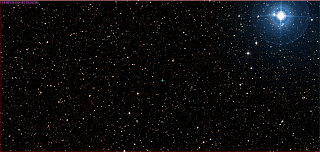

La C/2025 N1 (3I/ATLAS) non è una comune cometa come quelle che di solito precipitano verso il Sole provenienti dalla Nube di Oort, La sua non è un’orbita ellittica e neppure parabolica. È iperbolica con una eccentricità notevole: \(e ~ 6.13±0.02\). L’immagine qui a fianco mostra il punto d’ingresso di 3I/ATLAS nel Sistema Solare il giorno della sua scoperta. L’oggetto cometario è arrivato nel nostro Sistema Solare poco sopra il piano dell’eclittica dalle regioni più dense della Galassia: tra il Sagittario e il Serpente, poco sotto lo Scudo. Le prime stime della sua età sono strabilianti: 7.8 miliardi di anni, una volta e mezzo quella del Sole e meno della metà dell’Universo!

La C/2025 N1 (3I/ATLAS) non è una comune cometa come quelle che di solito precipitano verso il Sole provenienti dalla Nube di Oort, La sua non è un’orbita ellittica e neppure parabolica. È iperbolica con una eccentricità notevole: \(e ~ 6.13±0.02\). L’immagine qui a fianco mostra il punto d’ingresso di 3I/ATLAS nel Sistema Solare il giorno della sua scoperta. L’oggetto cometario è arrivato nel nostro Sistema Solare poco sopra il piano dell’eclittica dalle regioni più dense della Galassia: tra il Sagittario e il Serpente, poco sotto lo Scudo. Le prime stime della sua età sono strabilianti: 7.8 miliardi di anni, una volta e mezzo quella del Sole e meno della metà dell’Universo!

L’età avanzata di un oggetto che proviene dal bulge galattico potrebbe far pensare che in qualche modo la sua provenienza sia quella. Io penso di no.

La velocità d’ingresso nel Sistema Solare era alta \(~58\;km/s \).

Ora, arrotondando per eccesso a 60 e considerano “solo” 7 miliardi di anni di moto rettilineo uniforme \(Spazio = Velocità \times Tempo\),

\[60\ km/s\times 2.209032 \times10 ^{17} =1.33 \times10^{19} \ km\]

ovvero ~ 1.4 milioni di anni luce (ovviamente questo è un esercizio concettuale: nessun oggetto mantiene velocità costante per miliardi di anni dentro un ambiente dinamico come una galassia).

Ma tra il Sistema Solare e il bulge galattico ci sono solo 26 mila anni luce, quindi qualcosa non torna con 3I/ATLAS. Come può essere così antico e veloce? Se l’età è giusta, allora è la velocità è l’unica cosa che può essere cambiata, così come la traiettoria.

Questo significa che 3I/ATLAS potrebbe provenire da molto più lontano, non dal bulge magari, ma da regioni esterne alla Galassia o addirittura da un’altra galassia.

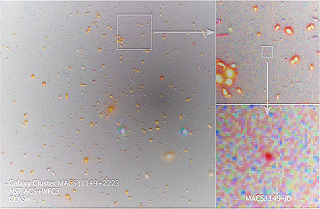

3I/ATLAS potrebbe essere un planetesimo appartenuto a una stella di Popolazione II di una galassia satellite poi cannibalizzata o di un ammasso globulare molto antico distrutto dalle forze mareali del bulge galattico circa 8 miliardi di anni fa. Questa ipotesi può facilmente spiegare parametri come l’elevatata eccentricità, l’orbita retrograda e l’elevata velocità iperbolica. Infatti, i valori mostrati da 3I/ATLAS sono decisamente troppo alti per un oggetto espulso da un sistema planetario appartenente alla Via Lattea e troppo bassi per un oggetto extragalattico. Ma perfettamente compatibili con un oggetto espulso durante una fusione galattica.

La Via Lattea ha inglobato diverse galassie nane nel corso della sua evoluzione, come la SagDEG (Sagittarius Dwarf Elliptical Galaxy) [1] e la Gaia-Enceladus [2]. Durante l’interazione mareale tra la galassia nana e la Via Lattea, le forze di marea e incontri ravvicinati con stelle massicce potrebbero aver espulso oggetti minori come 3I/ATLAS. Tramite questo meccanismo l’oggetto cometario avrebbe acquisito una velocità di fuga sufficiente a lasciarsi alle spalle il suo sistema d’origine, ma non la galassia ospite. Dopo la disgregazione della galassia nana, l’oggetto avrebbe vagato nel medio interstellare galattico, seguendo un’orbita caotica, fino a incrociare il Sistema Solare. Se 3I/ATLAS provenisse da una di queste galassie, la sua velocità di 68 km/s e la sua orbita iperbolica sarebbero il risultato di un’interazione dinamica antica, avvenuta miliardi di anni fa.

Ovviamente questa non è l’unica ipotesi, ma è una delle più affascinanti perché collega la cometa a eventi galattici antichi e a dinamiche cosmiche su scala galattica.

L’enigma chimico: nichel tetracarbonile

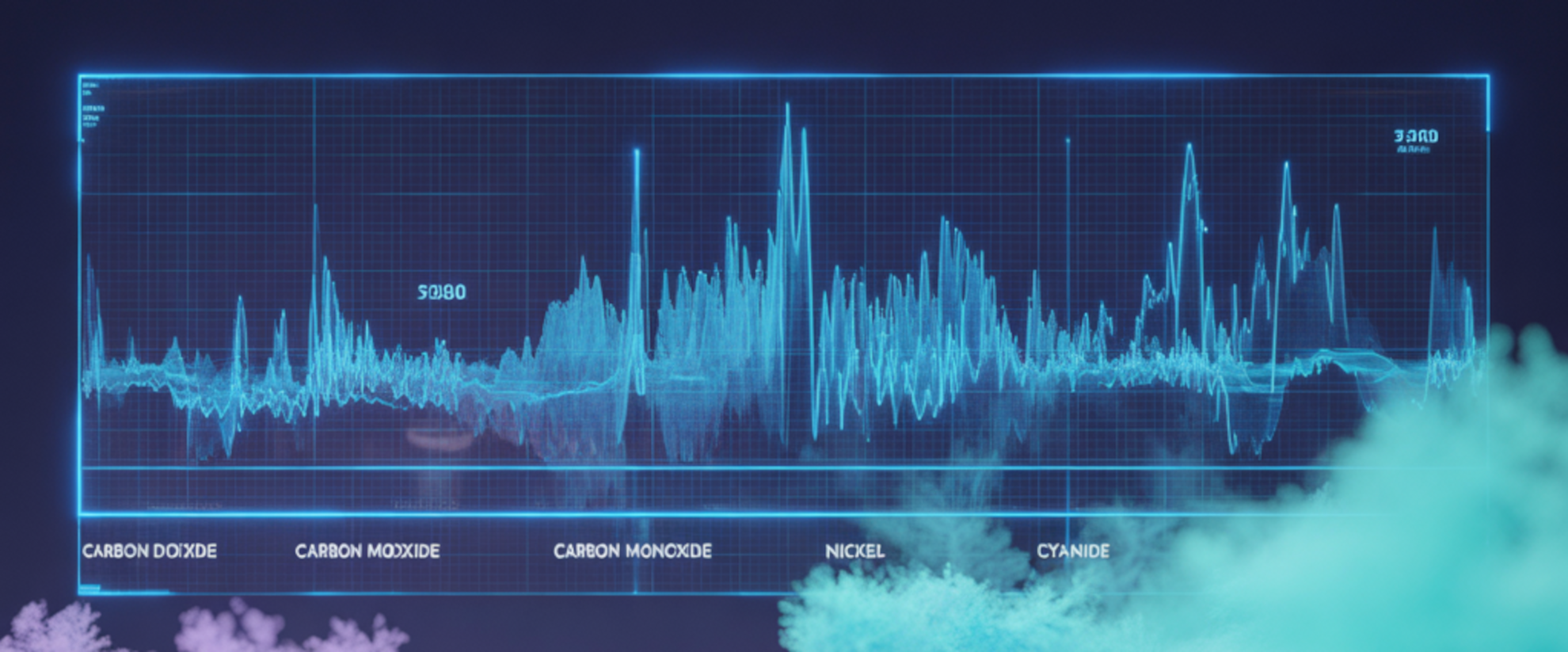

Tra le righe di emissione del monossido di carbonio e il cianuro (quasi assente) c’è una importante riga che appartiene al nichel, che in 3I/ATLAS è molto più abbondante del ferro.

La 3I/ATLAS ha mostrato una combinazione di firme chimiche mai osservate prima: un rapporto \(CO_{2}/H_{2}O\;\text{di}\;19.55:1\), emissioni intense di nickel senza tracce di ferro, e una dinamica che lo colloca tra gli oggetti più energetici mai entrati nel Sistema Solare.

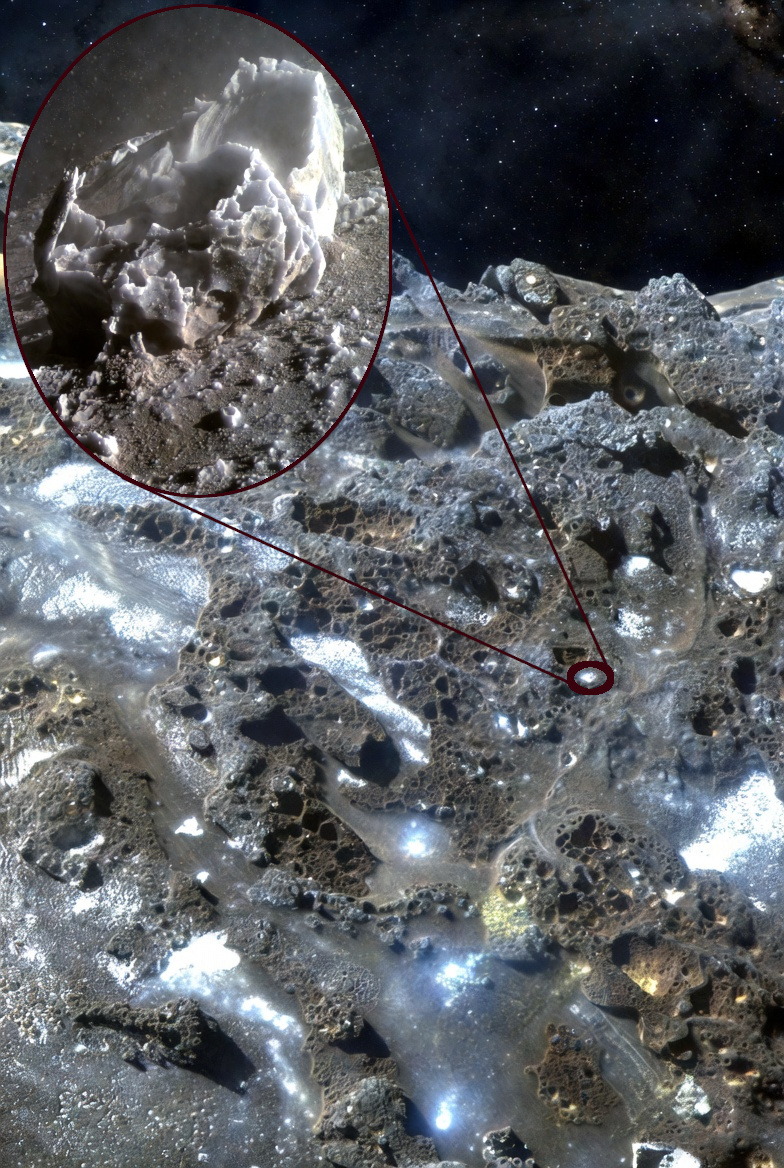

I primi segni tipici di attività cometaria sono stati osservati quando l’oggetto interstellare era a circa 3 AU dal Sole, il che non è insolito per quella distanza. Era ossidrile (\(OH\)) prodotto dalla fotodissociazione ultravioletta delle molecole d’acqua in ragione di circa 40 kg/sec (stechiometricamente circa 88 kg di acqua per secondo). Ma la temperatura superficiale della cometa a quella distanza è di circa 100-120 K (-173°C a -153°C), calcolata con la legge di Stefan-Boltzmann \(\left( T\approx \left( S/ \sigma \right)^\frac{1}{4}\right)\), dove \(S\) è la costante solare ridotta a 162 W/m² a 2,9 UA). Questo significa che in quella regione dello spazio è ancora troppo freddo per la sublimazione diretta del ghiaccio d’acqua, che richiede almeno 150-200 K. Ma potrebbe essere in gioco un altro meccanismo di sublimazione indiretto: piccoli grani di ghiaccio d’acqua, espulsi dalla sublimazione di ghiaccio di \(CO\) o \(CO_{₂}\) (più volatili), vengano dissociati dalla radiazione UV solare a 4.000-10.000 km dal nucleo.

La cosa più eccitante è che lo spettro della cometa a quella distanza mostra anche una grande firma legata al nichel (\(Ni \;\text{I}\)) ma non al ferro, comunemente associato a questo elemento. Il nichel atomico gassoso è stato trovato nella coma di 3I/ATLAS nel agosto scorso dal telescopio Keck II a una distanza di ~3.8 UA dal Sole.

Una plausibile spiegazione è che sia il risultato della fotodissociazione ultravioletta del nichel tetracarbonile \(Ni\left( CO \right)_{4}\)- una sostanza che sulla Terra usiamo in industria ma che nello spazio ancora non è mai stata osservata direttamente, ma solo ipotizzata [3], [4].

il nichel tetracarbonile è un complesso organometallico che si decompone facilmente col calore. la sua temperatura di fusione è di 248 K. Ma come può essersi formato questo complesso? Ce lo spiega questo studio [5] pubblicato su ResearchGate, ed è molto intrigante.

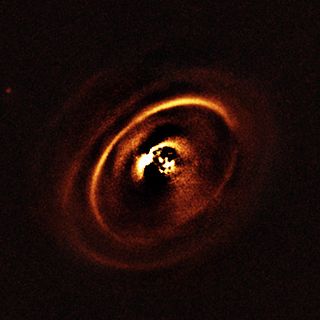

L’ipotesi in questo articolo

Immaginiamo un planetesimo di ghiaccio che orbita nella nube di Oort attorno a una gigante rossa AGB 1 di Pop. II di una antica galassia satellite della Via Lattea. Una supergigante col rapporto \(C/O\gt 1\) e venti stellari ricchi di radicali \(C, C_{2}, CN\). In un ambiente così ricco di carbonio, qualunque metallo che condensa interagisce con superfici carboniose.

E il nichel è proprio uno di quei metalli di transizione capaci di adsorbire il carbonio e catalizzare la sua polimerizzazione e altri processi complessi. Questo non è un dettaglio marginale: è la base della chimica industriale del carbonio. La chimica del tetracarbonile di nickel è sorprendentemente “facile” se si hanno le condizioni giuste:

- \(Ni\) metallico non ossidato o \(Ni^{0}\)

- \(CO\) in grande abbondanza

- basse temperature (50–200 K)

- pressioni moderate (10⁻⁶–10⁻³ bar)

- assenza di ossigeno libero

Tutte queste sono proprio le condizioni del vento di una stella asintotica ricca di carbonio e della successiva fase di raffreddamento dei grani. La formazione del nichel tetracarbonile diventa spontanea quando la temperatura dello spazio scende sotto i 200 K.

\[Ni^0 + 4\; CO\to Ni\left( CO \right)_{4}\]

È una reazione esotermica e spontanea, favorita dalle basse temperature e dall’eccesso di \(CO\). In pratica è la medesima reazione che Mond scoprì nel 1890, e che ancora oggi si usa industrialmente per purificare il nickel, solo che in questo caso siamo su scala stellare.

Riassumendo: il vento stellare di una gigante asintotica può essere riassunto in due momenti. Una fase calda (1300-1500 K) in cui avviene la condensazione dei solfuri di nichel (\(NiS, Ni_{3}S_{2}\)) e agglomerati di nichel non ossidato. E una fase fredda (200 > 50 K),m in cui il nichel non ossidato e il monossido di carbonio sono liberi di interagire. Il vento stellare si espande, si raffredda, e gli agglomerati metallici vengono carbonilati 2.

Ma rimane un altro aspetto affascinante delle giganti asintotiche: i loro brevi ma potentissimi flash dell’elio 3; impulsi termici brevi ma potentissimi in cui il guscio dell’elio si accende violentemente, generando temperature di \(1-3 \times10^8 \;K\). Durante questi parossismi si ha una produzione massiccia di neutroni tramite la reazione \(^{13}C\left( \alpha,n \right)^{16}O\) 4.

Nel modello proposto da Young si calcola che ogni flash dell’elio raddoppi il rapporto \(Ni/Fe\) proprio per cattura neutronica (per ex. 6 flash, \(\to2^{6}\) = 64 volte più nichel del ferro. Ma questo non basta. Il nichel tende a formare solfuri volatili come ho precedentemente descritto, mentre il ferro invece si lega di più con i silicati e ossidi refrattari (olivine, pirosseni, \(FeO\)). E nella fase calda dei venti stellari, il nichel condensa con una efficienza attorno al 90% contro il 10% del ferro. Questo si traduce in un altro arricchimento del nichel a distanza molto maggiori della stella di circa 9 volte.

Combinando i due fattori, nucleosintesi e condensazione, e le debite correzioni al ribasso prudenziali, diciamo un efficienza dell’8%, si ottiene:

\[Ni/Fe \approx64\times9\times0.08 \approx 46\]

un valore praticamente identico al limite osservato in 3I/ATLAS (Ni/Fe > 46). Almeno finché la 3I/ATLAS era a una distanza eliocentrica di 2,7 UA.

Poi a una distanza eliocentrica di 2.6-2-5 UA ecco comparire la riga spettroscopica del \(Fe \;\text{I}\) 5. Tra i 2.6 e 2 UA il rapporto \(Ni/Fe\) crolla e a distanze ancora inferiori tale rapporto diventa praticamente uguale a quello di una comune cometa del Sistema Solare.

Il concetto è molto semplice ed elegante [6]:

il \(Ni\left( CO \right)_{4}\) sublima molto prima (3,5-4 UA) del \(Fe\left( CO \right)_{5}\) ( <2,6UA).

Per questo si è notata prima la grande presenza del nichel I e poi del ferro I. È un comportamento puramente termico che però non contraddice quanto finora detto sull’abbondanza del nichel primordiale nella cometa. In sostanza si tratta di un processo evolutiv0 dipendente dalla distanza dal Sole, lo straordinario e mutevole rapporto \(Ni/Fe\) che stiamo osservando.

Conclusione

Noi osserviamo unicamente la chioma di 3I/ATLAS, non il suo nucleo. Ma dal modo in cui si evolve il rapporto \(Ni/Fe\) si può intuire l’origine della cometa, che si è fissata approssimativamente tra i 7 e 11 miliardi di anni fa in orbita intorno a una gigante rossa asintotica di una galassia assorbita dalla Via Lattea, in un’area molto ricca di nichel e povera di ferro.

Io non credo a speculazioni di artefatti alieni e altre bischerate. Ogni cometa naturale ha movimenti non gravitazionali dipendenti dal criovulcanismo. 3I/ATLAS ha avuto 8 miliardi di anni di vuoto interstellare per accumulare ghiaccio che si è poi degradato grazie ai raggi cosmici. Per me è un planetesimo ricoperto di ghiaccio sporco che ci racconta una storia ben più intrigante di una mistica nave ‘liena. Con buona pace a chi ancora a quella strampalata ipotesi vuol ancora credere.

Cieli sereni

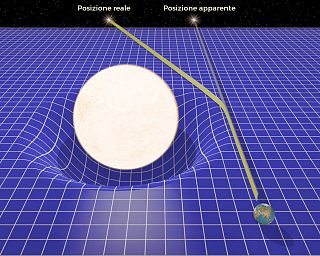

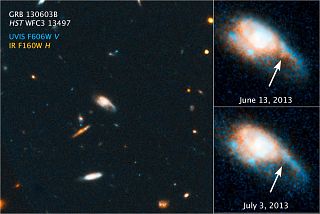

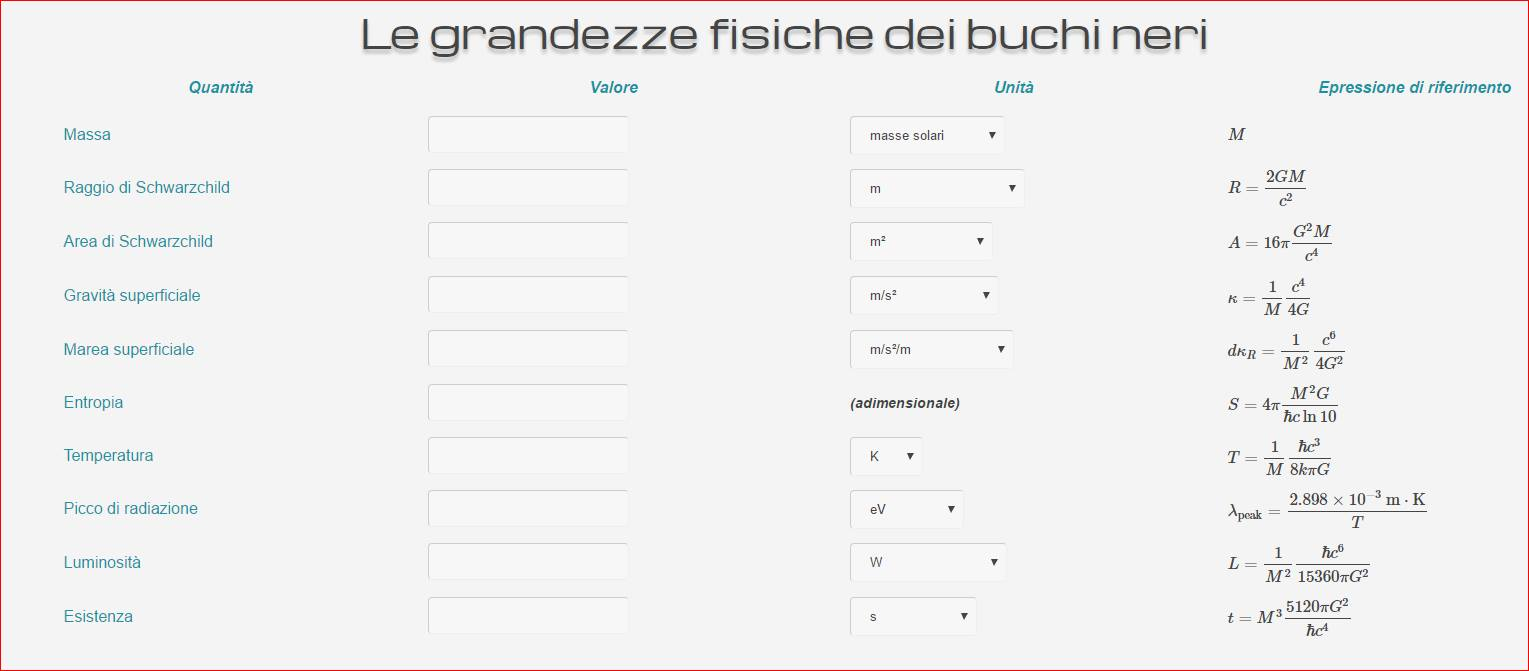

[/fancybox]Cliccando sull’immagine qui sopra vi si aprirà una finestra su cui potete sbizzarrirvi a studiare alcune delle bizzarre proprietà matematiche dei buchi neri.

[/fancybox]Cliccando sull’immagine qui sopra vi si aprirà una finestra su cui potete sbizzarrirvi a studiare alcune delle bizzarre proprietà matematiche dei buchi neri.