La radiazione di Hawking

Come ho cercato di spiegare nelle puntate scorse dedicate ai buchi neri [cite]https://ilpoliedrico.com/2017/03/il-principio-olografico-dei-buchi-neri-lorizzonte-degli-eventi.html[/cite], questi curiosi oggetti hanno diverse peculiarità uniche definibili solo matematicamente.

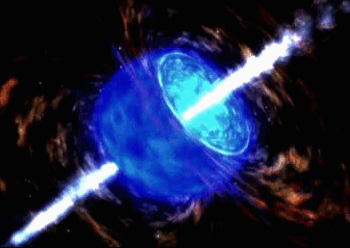

Sulla base della convinzione — corretta — che niente può viaggiare più veloce della luce si era supposto quindi che nulla potesse sfuggire da un buco nero. Tecnicamente è ancora corretto pensare questo, ma nel 1974 il cosmologo Stephen Hawking dimostrò che in realtà i buchi neri emettono una radiazione termica di corpo nero diversa da zero. Il ragionamento che è alla base di questa scoperta è che lo spazio non è mai esattamente vuoto ma ribolle di energia che si manifesta con la produzione spontanea di coppie di particelle e antiparticelle virtuali, ovvero che la loro esistenza è limitata dal Principio di Indeterminazione di Heisenberg [cite]https://ilpoliedrico.com/2016/07/zenone-olbers-lenergia-oscura-terza-parte.html[/cite].

Quando queste fluttuazioni del vuoto si manifestano in prossimità dell’orizzonte degli eventi di un buco nero può capitare che una coppia di particelle virtuali finisca oltre l’orizzonte (A nella figura); in tal caso l’equilibrio energetico complessivo del’universo e la massa/energia del buco nero non variano, come impone il Principio della Conservazione della massa/energia. Lo stesso ovviamente accade anche per le particelle virtuali che si annichiliscono spontaneamente nello spazio normale (scenario B nella figura). Ma può capitare che soltanto una di queste finisca oltre l’orizzonte degli eventi (vedi evento C); questo scenario potrebbe far da principio supporre che esso violi il postulato precedente in quanto la particella che riesce a non finire oltre l’orizzonte degli eventi diviene una particella reale, ma in realtà non è così. La particella che cade nel buco nero è l’antiparticella di quella che sfugge, ossia possiede alcuni numeri quantici opposti rispetto ad essa. Questo non viola il Principio di Conservazione della massa/energia perché il buco nero acquista una particella opposta al resto dell’universo e la somma totale dell’energia rimane invariata. Ma se adesso nell’universo c’è la massa/energia di una particella in più allora significa che il processo iniziale sottrae la medesima quantità di massa/energia al buco nero. Per un ideale osservatore lontano la nuova particella appare provenire dal buco nero, ma in realtà essa ha origine nello spazio normale appena oltre l’orizzonte degli eventi.

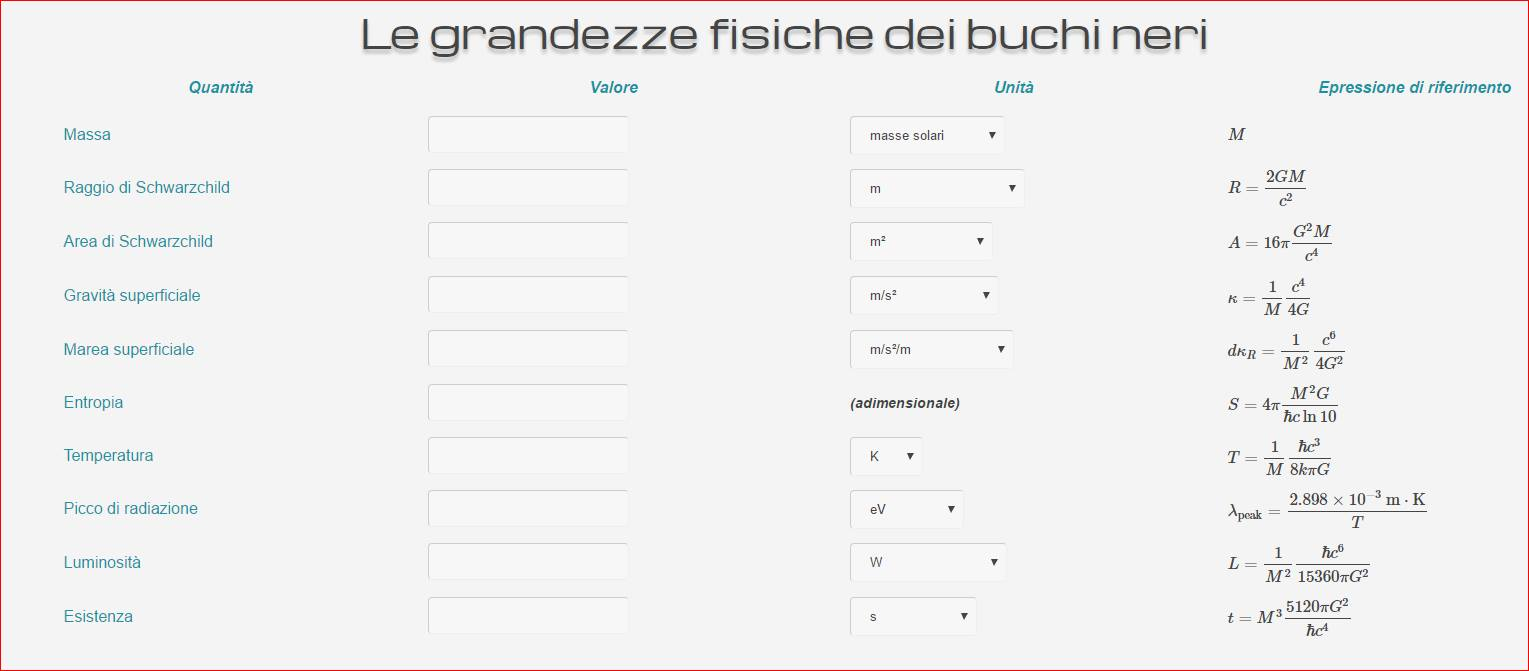

[/fancybox]Cliccando sull’immagine qui sopra vi si aprirà una finestra su cui potete sbizzarrirvi a studiare alcune delle bizzarre proprietà matematiche dei buchi neri.

[/fancybox]Cliccando sull’immagine qui sopra vi si aprirà una finestra su cui potete sbizzarrirvi a studiare alcune delle bizzarre proprietà matematiche dei buchi neri.Questa intuizione di Stephen Hawking, che ricordo ebbe origine anche dai lavori di due scienziati sovietici, Yakov Zeldovich e Alexei Starobinsky, che fin dagli inizi degli anni 70 del secolo scorso avevano ipotizzato la generazione di particelle attorno ai buchi neri rotanti (1973/74), dimostra che i buchi neri in effetti possano perdere massa tramite la radiazione che porta, appunto, il suo nome.

Quindi, in un certo senso i buchi neri non sono poi così neri. Il lavoro di Hawking ha spinto altri cosmologi a studiare più in dettaglio i buchi neri fino a postulare le loro leggi termodinamiche [cite]https://ilpoliedrico.com/2017/03/il-principio-olografico-dei-buchi-neri-la-termodinamica.html[/cite], il noto Principio Olografico e altre bizzarre proprietà che in queste pagine posso solo elencare solo parzialmente.

Giocando con i calcoli

Giostrando un po’ coi diversi parametri nella pagina che ho creato (è presente anche nel menù a discesa sotto la voce “Science”) si nota come i buchi neri siano ancora più strani di quel che si pensi.

Ad esempio, la temperatura di un buco nero, conseguenza della Radiazione di Hawking, è inversamente proporzionale alla sua massa ossia un buco nero piccolo irradia di più di uno di massa più grande.

L’attuale fondo di radiazione cosmica ha una temperatura di 2.72 kelvin; perché un buco nero sia termicamente rilevabile dovrebbe poter emettere a una temperatura appena superiore. Ma i numeri sono impietosi: un siffatto buco nero sarebbe grande appena 67μm, circa quanto lo spessore di un capello umano, e quindi — almeno con gli strumenti attuali — impossibile da rilevare direttamente.

Un buco nero capace di emettere alla stessa temperatura del Sole, ovvero 5778 kelvin, sarebbe grande appena 30 nanometri, quanto cioè la giunzione di un transistor in un processore di qualche anno fa. Avrebbe ancora una vita molto lunga prima di evaporare, circa 2,5 x 1034 anni, comunque moltissime volte di più dell’età attuale dell’Universo.

Magari una civiltà avanzatissima potrebbe essere in grado di imbrigliare un micro buco nero ed avere così una fonte virtualmente infinita di energia.

Non voglio levarvi il divertimento di provare a fare nuove speculazioni con le cifre che si possono ricavare dalla tabella. Anzi vi invito a farlo e poi a condividerle nei commenti.

Cieli sereni