Prima di scrivere questo pezzo ho fatto una scorsa dei risultati che restituiscono i motori di ricerca sul Principio Olografico, giusto per curiosità. Ne è uscito un quadro desolante; da chi suggerisce che siamo tutti ologrammi alla medicina quantistica (roba di ciarlatani creata per i beoti). Ben pochi hanno descritto il modello e ancora meno (forse un paio sparsi nella profondità suggerita dal ranking SEO) hanno scritto che si tratta solo di un modello descrittivo. Cercherò ora di aggiungere il mio sussurro al loro, giusto per farli sentire un po’ meno soli.

Essenzialmente il mezzo più immediato e naturale che usiamo per descrivere il mondo che circonda è dato dalla vista. Essa però restituisce unicamente un’immagine bidimensionale della realtà, esattamente come fanno anche una fotografia o un quadro. Ci viene in soccorso la percezione della profondità spaziale, dove la terza dimensione emerge grazie all’effetto prospettico che fa apparire più piccole e distorte le immagini sullo sfondo rispetto a quelle in primo piano. L’unico mezzo veramente efficace che abbiamo per cercare di rappresentare correttamente la realtà è la matematica, anche se essa appare spesso controintuitiva.

Ripetendo in parte ciò che ho detto in altre occasioni, l’Uomo ha sempre cercato di dare una spiegazione convincente a tutto quello che lo circonda, che per brevità di termine chiamiamo realtà. Ad esempio, la scoperta delle stagioni, il costante ripetersi ogni anno delle diverse levate eliache e i cicli lunari sono culminati nell’invenzione del calendario, che nelle sue varie interpretazioni e definizioni, ha sempre accompagnato l’umanità. Eppure esso in astratto non è che un modello, grossolano quanto si vuole, ma che consente di prevedere quando sarà la prossima luna nuova o l’astro Sirio allo zenit a mezzanotte.

Anticamente anche le religioni erano modelli più o meno astratti che avevano il compito di spiegare ad esempio, i fulmini, le esondazioni, le maree, il giorno e la notte, etc.

Oggi sappiamo che i fulmini sono una scarica elettrica, che il giorno e la notte sono la conseguenza della rotazione terrestre e che le esondazioni avvengono perché da qualche altra parte piove.

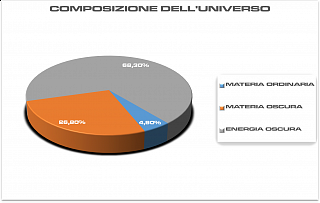

Abbiamo teorizzato per secoli una cosmologia geocentrica e solo più tardi quella eliocentrica, quando abbiamo capito che la prima era sbagliata. Abbiamo accarezzato per un breve periodo l’idea galattocentrica prima di apprendere che le galassie erano più di una e il Sole era solo una comune stellina grossomodo a metà strada fra il centro e la periferia della Via Lattea, e abbiamo anche creduto ad un universo statico prima di scoprire che l’Universo si espandeva in dimensioni.

Anche tutti questi erano modelli e modelli pensati su altri modelli dati per sicuri finché non venivano dimostrati sbagliati. E questo vale anche per i modelli attuali e le teorie fino ad oggi considerate certe.

L’orizzonte degli eventi.

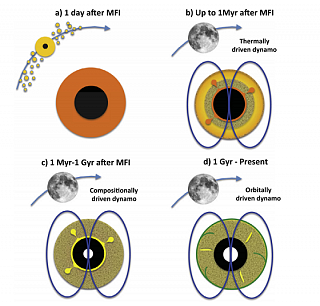

Il raggio dell’orizzonte degli eventi di un buco nero è restituito da questa formula matematica che stabilisce l’equilibrio tra gravità e velocità della luce. Esso esiste solo teoricamente perché si suppone che l’oggetto che ha dato origine al buco nero abbia avuto con sé un certo momento angolare che poi si è conservato.

Infatti, per descrivere matematicamente un buco nero reale si usa una metrica leggermente diversa che tiene conto anche del campo elettromagnetico e del momento angolare: quella di Kerr-Newman.

Già alla fine del 1700 si teorizzava di una stella tanto densa e massiccia da ripiegare la luce con la sua gravità. John Michell e Pierre-Simon de Laplace la chiamavano stella oscura. Ma fu solo dopo il 1915, con la Relatività Generale, che Karl Schwarzschild trovò le equazioni che descrivevano il campo gravitazionale di un oggetto capace di ripiegare la luce su di sé. Così fu evidente che esiste un limite, un orizzonte oltre il quale neppure la luce può sfuggire. Non è un limite solido, tangibile come quello di una stella o di un pianeta come talvolta qualcuno è portato a immaginare, ma è un limite matematico ben preciso definito dall’equilibrio tra la gravità e la velocità della luce, che è una costante fisica assoluta 1.

La relatività insegna che niente è più veloce della luce. Pertanto, basandosi solo su questo assioma, è ragionevole pensare che qualsiasi cosa oltrepassi l’orizzonte degli eventi di un buco nero sia definitivamente persa e scollegata dal resto dell’universo. Questa interpretazione, chiamata teorema dei buchi neri che non hanno capelli o No Hair Theorem, niente, più nessuna informazione potrebbe uscire una volta oltrepassato quel limite. Infatti se descrivessimo matematicamente un buco nero usando la metrica di Kerr-Newman – è una soluzione delle equazioni di Einstein-Maxwell della Relatività Generale che descrive la geometria dello spazio-tempo nei pressi di una massa carica in rotazione – viene fuori che un buco nero può essere descritto unicamente dalla sua massa, il momento angolare e la sua carica elettrica [1].

Cercare di spiegare la complessità dello spazio-tempo in prossimità degli eventi senza ricorrere alla matematica è un compito assai arduo.

Cercare di spiegare la complessità dello spazio-tempo in prossimità degli eventi senza ricorrere alla matematica è un compito assai arduo.

L’oggetto che descrive Shwartzschild è solo il contorno osservabile di un buco nero. Ciò che vi finisce oltre scompare all’osservatore esterno in un tempo infinito. Egli vedrebbe che il tempo sul bordo degli eventi si ferma mentre la lunghezza d’onda della luce gli apparirebbe sempre più stirata 2 in rapporto alla sua metrica temporale, man mano che essa proviene da zone ad esso sempre più prossime fino a diventare infinita.

Invece, volendo fare un gedankenexperiment [cite]https://it.wikipedia.org/wiki/Esperimento_mentale[/cite] come avrebbe detto Einstein, per colui che cercasse di oltrepassare l’orizzonte degli eventi – ammesso che sopravviva tanto da raccontarlo – il tempo risulterebbe essere assolutamente normale e tramite misure locali non noterebbe alcuna curvatura infinita dello spaziotempo e finirebbe per oltrepassare l’orizzonte degli eventi in un tempo finito.

Appare controintuitivo ma è così. Se dovessimo assistere come osservatore privilegiato alla formazione di un buco nero dal collasso di una stella [cite]https://ilpoliedrico.com/2017/02/supernova.html[/cite], non vedremmo mai il nocciolo stellare oltrepassare l’orizzonte degli eventi. Noteremmo solo che la luce proveniente da esso diventa sempre più fioca: vedremmo che i raggi gamma più duri emessi dal nocciolo diventare raggi X, poi luce visibile, infrarosso e radio e poi più nulla; nessuna radiazione, più nessuna informazione proveniente dal nocciolo stellare potrebbe più raggiungerci.

Quello che c’è oltre lo chiamiamo singolarità. Le leggi fisiche a noi note non possono più descrivere cosa succede oltre l’orizzonte degli eventi e tutto ciò che lo oltrepassa non può più comunicare il suo stato all’esterno.

È difficile descrivere ciò che non si può osservare.

[/fancybox]

[/fancybox]