[latexpage]

La scoperta di un enorme numero dei pianeti extrasolari in questi ultimi vent’anni ha sicuramente rivoluzionato l’idea di Cosmo. A giugno di quest’anno erano oltre 1100 i pianeti extrasolari scoperti e accertati nel catalogo di exoplanet.eu, facendo stimare, con le opportune cautele dovute a ogni dato statistico, a circa 60 miliardi di pianeti potenzialmente compatibili con la vita. Questo impressionante numero però non deve far credere immediatamente che 60 miliardi di mondi siano abitabili; Venere, che dimensionalmente è molto simile alla Terra, è totalmente incompatibile con la vita terrestre che, probabilmente, si troverebbe più a suo agio su Marte nonostante questo sia totalmente ricoperto da perossidi, continuamente esposto agli ultravioletti del Sole e molto più piccolo del nostro globo.

In concreto come si fa a calcolare i parametri fisici di un pianeta extrasolare? Prendiamo l’esempio più facile, quello dei transiti. Questo è il metodo usato dal satellite della NASA Kepler, che però soffre dell’handicap geometrico del piano planetario che deve giacere sulla stessa linea di vista della stella,o quasi. Ipotizziamo di stare osservando una debole stellina di 11a magnitudine, che però lo spettro indica come una K7:

La distanza

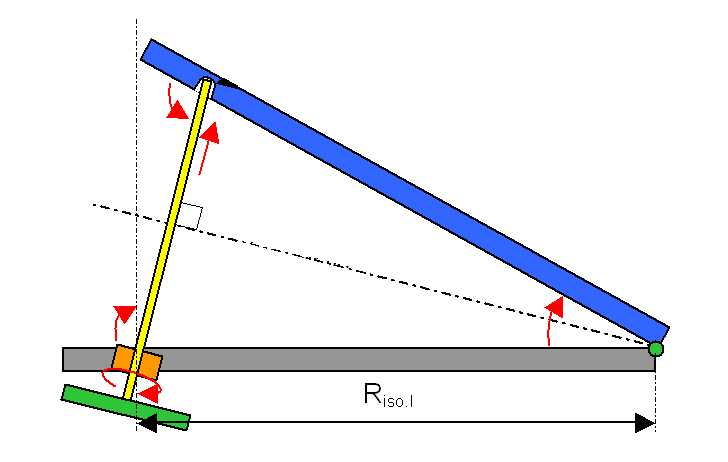

La tabella di Morgan-Keenan suggerisce per questo tipo di stella una massa di 0,6 masse solari, una temperatura superficiale di appena 4000 K. e un raggio pari a 0,72 volte quello del Sole. Analizzando invece questo ipotetico diagramma del flusso di luce 1 proveniente dalla stella, appare evidente la periodicità dell’affievolimento (qui esagerato) della sua luce.

Un periodo pari a 76,86 giorni terrestri, un classico evento tipico anche di una semplice binaria ad eclisse per esempio, solo molto più veloce. Un semplice calcolo consente di trasformare il periodo espresso qui in giorni in anni (o frazioni di esso). Pertanto il suo periodo rispetto agli anni terrestri è $76,86/365,25= 0,2104$. A questo punto è sufficiente applicare la terza Legge di Keplero per ottenere la distanza del pianeta dalla sua stella espresso in unità astronomiche:

\begin{equation} D_{UA}^3=P_y^2\cdot M_{\bigstar}= \sqrt[3]{0,2104^2 \cdot 0,.6}= 0,2983 \end{equation} Quindi l’esopianeta scoperto ha un periodo orbitale di soli 76,86 giorni e orbita a una distanza media di sole 0,2368 unità astronomiche dalla stella, ossia a poco più di 44.6 milioni di chilometri dalla stella. Una volta scoperto quanto dista il pianeta dalla stella è facile anche calcolare la temperatura di equilibrio del pianeta, per vedere se esso può – in linea di massima – essere in grado di sostenere l’acqua allo stato liquido.

La temperatura di equilibrio

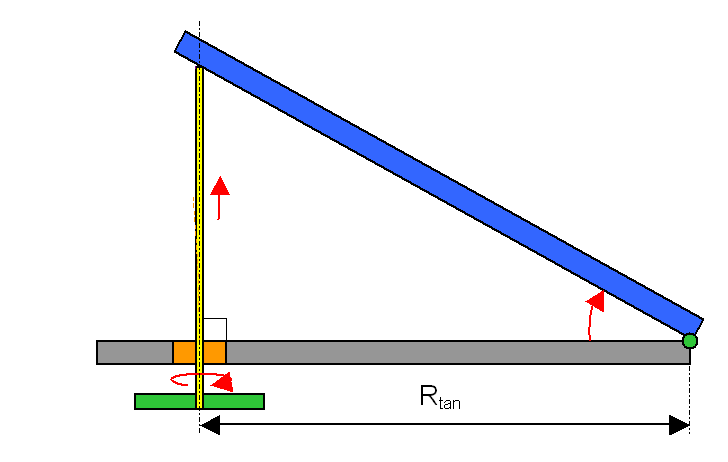

| \begin{equation}\frac{\pi R_p^2}{4\pi d^2} = \left ( \frac{R_p}{2d}\right )^2\end{equation} L’energia intercettata da un pianeta di raggio $R_p$ in orbita alla sua stella a una distanza $d$ |

Per comodità di calcolo possiamo considerare una stella come un perfetto corpo nero ideale. La sua luminosità è perciò dettata dall’equazione: $L_{\bigstar}=4\pi R_{\bigstar}^2\sigma T_{\bigstar}^4$, dove $\sigma$ è la costante di Stefan-Boltzmann che vale $5,67 \cdot{10^{-8}} W/m^2 K^4$). Qualsiasi pianeta di raggio $R_p$ che orbiti a distanza $d$ dalla stella cattura soltanto l’energia intercettata pari alla sua sezione trasversale $\pi R_p^2$ per unità di tempo e divisa per l’area della sfera alla distanza $d$ dalla sorgente. Pertanto si può stabilire che l’energia intercettata per unità di tempo dal pianeta è descritta dall’equazione: \begin{equation} 4\pi R_{\bigstar}^2\sigma T_{\bigstar}^4\times \left ( \frac{R_p}{2d}\right )^2 \end{equation}

Ovviamente questo potrebbe essere vero se il pianeta assorbisse tutta l’energia incidente, cosa che per fortuna così non è, e riflette nello spazio parte di questa energia. Questa frazione si chiama albedo ed è generalmente indicata con la lettera $A$. Quindi la precedente formula va corretta così: \begin{equation} \left ( 1-A \right ) \times 4\pi R_{\bigstar}^2\sigma T_{\bigstar}^4\times \left ( \frac{R_p}{2d}\right )^2 \end{equation}

Il pianeta (se questo fosse privo idealmente di una qualsiasi atmosfera) si trova così in uno stato di sostanziale equilibrio termico tra l’energia ricevuta, quella riflessa dall’albedo e la sua temperatura. L’energia espressa dal pianeta si può descrivere matematicamente così: $L_{p}= 4\pi R_{p}^2\sigma T_{p}^4$ e, anche qui per comodità di calcolo, si può considerare questa emissione come quella di un qualsiasi corpo nero alla temperatura $T_p$. Pertanto la temperatura di equilibrio è: \begin{equation}

4\pi R_{p}^2\sigma T_{p}^4 =\left ( 1-A \right ) \times 4\pi R_{\bigstar}^2\sigma T_{\bigstar}^4\times \left ( \frac{R_p}{2d}\right )^2 \end{equation}

Ora, semplificando quest’equazione si ottiene: \begin{equation} T_{p}^4= (1-A)T_{\bigstar}^4 \left ( \frac{R_{\bigstar}}{2d}\right )^2 \rightarrow T_{p}=T_{\bigstar}(1-A)^{1/4}\sqrt { \frac{R_{\bigstar}}{2d}} \end{equation}

Con i dati ottenuti in precedenza è quindi possibile stabilire la temperatura di equilibrio dell’ipotetico esopianeta ipotizzando un albedo di o,4: \begin{equation}

T_{p}=4000 \enskip K \cdot 0,6 ^{1/4}\sqrt { \frac{500 000 \enskip km}{2\cdot 4,46\cdot 10^7\enskip km}} =263,47 \enskip K.

\end{equation}

Risultato: l’esopianeta pare in equilibrio termico a -9,68 °C, a cui va aggiunto alla superficie l’effetto serra causato dall’atmosfera. Ma in fondo, anche le dimensioni contano …

Il raggio

Il calo della luminosità indica le dimensioni dell’oggetto in transito: $r^2/R^2$

Nel momento del transito, si registra un calo della luminosità della stella. L’ampiezza di questo calo rispetto alla luminosità standard della stella fornisce una stima della misura del raggio del pianeta. Il calo non è immediato, ma segue un andamento proporzionale alla superficie del pianeta occultante, uguale sia in ingresso che in uscita. In base a queste osservazioni si possono ricavare i flussi di energia luminosa (indicati appunto dalla lettera $F$) provenienti nei momenti del transito. $F_{\bigstar}$ è la quantità di energia luminosa osservata nella fase di non transito, normalmente normalizzato a 1, mentre l’altra $F_{transito}$ rappresenta il flusso intercettato nel momento di massimo transito:. la differenza tra i due flussi ( $\frac{\Delta F}{F}=\frac{F_{\bigstar}-F_{transito}}{F_{\bigstar}}$) è uguale alla differenza tra i raggi della stella e del pianeta.

\begin{equation} R_p=R_{\bigstar}\sqrt{\frac{\Delta F}{F}} \end{equation}

Il diagramma (ipotetico) a destra nell’immagine qui sopra mostra che il punto più basso della luminosità è il 99,3% della luminosità totale. Risolvendo questa equazione per questo dato si ha: \begin{equation} \frac{R_{p}}{R_{\bigstar}}=\sqrt{\frac{\Delta F}{F}} =\sqrt{\Delta F} = \sqrt{1-0,993}=\sqrt{0,007}=0,08366 \end{equation}

Conoscendo il raggio della stella, 500000 km, risulta che l’esopianeta ha un raggio di quasi 42 mila chilometri, quasi il doppio di Nettuno!

Seconda Parte

Errata corrige

Un banale errore di calcolo successiva all’equazione (1) ha parzialmente compromesso il risultato finale dell’equazione (7) e del risultato della ricerca. Il valore della distanza del pianeta dalla sua stella è di 44,6 milioni di chilometri invece dei 35,4 milioni indicati in precedenza. Ci scusiamo con i lettori per questo spiacevole inconveniente prontamente risolto.

Note: