Notizia di queste ore è la scoperta di un nuovo pianeta che orbita attorno a una nana rossa (M4) a 18 anni luce di distanza. E giù tutti i simpatici giornaloni a dire una nuova Super Terra, quasi fosse Tahiti, magari abitata da gnomi di Babbo Natale in bermuda e mohito.

Io tutto questo entusiasmo che vedo in giro non lo capisco.

Il pianeta ha una propria rotazione assiale o è bloccato in risonanza con la sua stella? La sua massa la sappiamo, ma la densità? Da questo dipende la gravità in superficie. Al massimo (ammesso abbia una densità simile alla Terra potremo aspettarci un’atmosfera particolarmente ricca di carbonio affinché si raggiunga il punto triplo dell’acqua (273 K), perché la sua temperatura di equilibrio è a 216 K. In queste condizioni, probabilmente la forma di vita più evoluta sarà qualche lichene nero (la radiazione di corpo nero della stella influisce sui processi di fotosintesi) in un’atmosfera per noi tossica. Facciamo due conti.

A soli 18 anni luce dalla Terra, GJ 251c è una Super Terra che ha acceso l’interesse di astronomi e divulgatori. Ma dietro l’entusiasmo dei titoli di giornale, si nascondono alcune domande cruciali per stabilirne l’abitabilità: ha una rotazione propria? Qual è la sua densità? E soprattutto: può davvero ospitare vita?

A soli 18 anni luce dalla Terra, GJ 251c è una Super Terra che ha acceso l’interesse di astronomi e divulgatori. Ma dietro l’entusiasmo dei titoli di giornale, si nascondono alcune domande cruciali per stabilirne l’abitabilità: ha una rotazione propria? Qual è la sua densità? E soprattutto: può davvero ospitare vita?

Parametri orbitali e fisici

- Massa: \( M_p \approx 4 M_\oplus \)

- Periodo orbitale: \( P \approx 54 \, \text{giorni} \)

- Temperatura di equilibrio: \( T_{eq} \approx 216 \, \text{K} \)

Densità e gravità superficiale

\[ \frac{R_p}{R_\oplus} = \left( \frac{M_p / M_\oplus}{\rho_p / \rho_\oplus} \right)^{1/3} \]

\[ \frac{g_p}{g_\oplus} = \frac{M_p / M_\oplus}{(R_p / R_\oplus)^2} \]

Assumendo una densità tra \(\rho_p = 4-5 \ \text{g/cm}^3\) 1 [1], si possono stimare il raggio e la gravità con \( \rho_p = 4.5 \, \text{g/cm}^3 \) e \( \rho_\oplus = 5.51 \, \text{g/cm}^3 \):

Raggio relativo rispetto alla Terra:

\[ \frac{R_p}{R_\oplus} = \left( \frac{4}{4.5 / 5.51} \right)^{1/3} = \left( \frac{4}{0.816} \right)^{1/3} \approx 1.70 \]

E la relativa gravità superficiale (sempre rispetto alla Terra):

\[ \frac{g_p}{g_\oplus} = \frac{4}{(1.70)^2} \approx 1.38 \]

Rotazione e distribuzione termica

Con un periodo orbitale di 54 giorni attorno a una nana rossa, è altamente probabile che Gliese 251c sia bloccato marealmente o in risonanza spin-orbita 2 .

Un blocco mareale stretto, come quello della Luna con la Terra per esempio, implicherebbe che un emisfero del pianeta sia perennemente illuminato, l’altro al buio. In questo caso saremmo di fronte a forti gradienti termici, mitigabili solo da un’atmosfera particolarmente densa e dinamica.

Però potrebbero esserci ancora delle zone potenzialmente sostenibili limitate al terminatore (la fascia tra il giorno e la notte).

Anche in questo caso la matematica ci dice perché:

Tempo di sincronizzazione mareale

La formula estesa è [2]:

\[

t_{\text{sync}} = \frac{\omega a^6 I Q}{3 G m_S^2 k_2 R_P^5}

\]

Dove:

- \( \omega \): velocità angolare iniziale

- \( a \): distanza dal corpo centrale

- \( I = \frac{2}{5} m_p R_P^2 \): momento d’inerzia

- \( Q \): fattore di dissipazione

- \( G = 6.674 \times 10^{-11} \, \text{m}^3 \, \text{kg}^{-1} \, \text{s}^{-2} \)

- \( m_s \): massa del corpo centrale

- \( k_2 \): numero di Love

- \( R_P \): raggio del pianeta

Per GJ 251c:

\[ I = \frac{2}{5} \cdot 2.39 \times 10^{25} \cdot (1.08 \times 10^7)^2 \approx 1.11 \times 10^{39} \]

\[ \omega = \frac{2\pi}{86400} \approx 7.27 \times 10^{-5} \]

\[ t_{\text{sync}} \approx \frac{(7.27 \times 10^{-5}) \cdot (3.29 \times 10^{10})^6 \cdot (1.11 \times 10^{39}) \cdot 100}{3 \cdot 6.674 \times 10^{-11} \cdot (7.16 \times 10^{29})^2 \cdot 0.3 \cdot (1.08 \times 10^7)^5} \]

\[ t_{\text{sync}} \approx 1.2 \times 10^7 \, \text{anni} \]

Quasi certamente il nostro pianeta è in uno stato di blocco mareale con la sua stella.

Una plausibile atmosfera

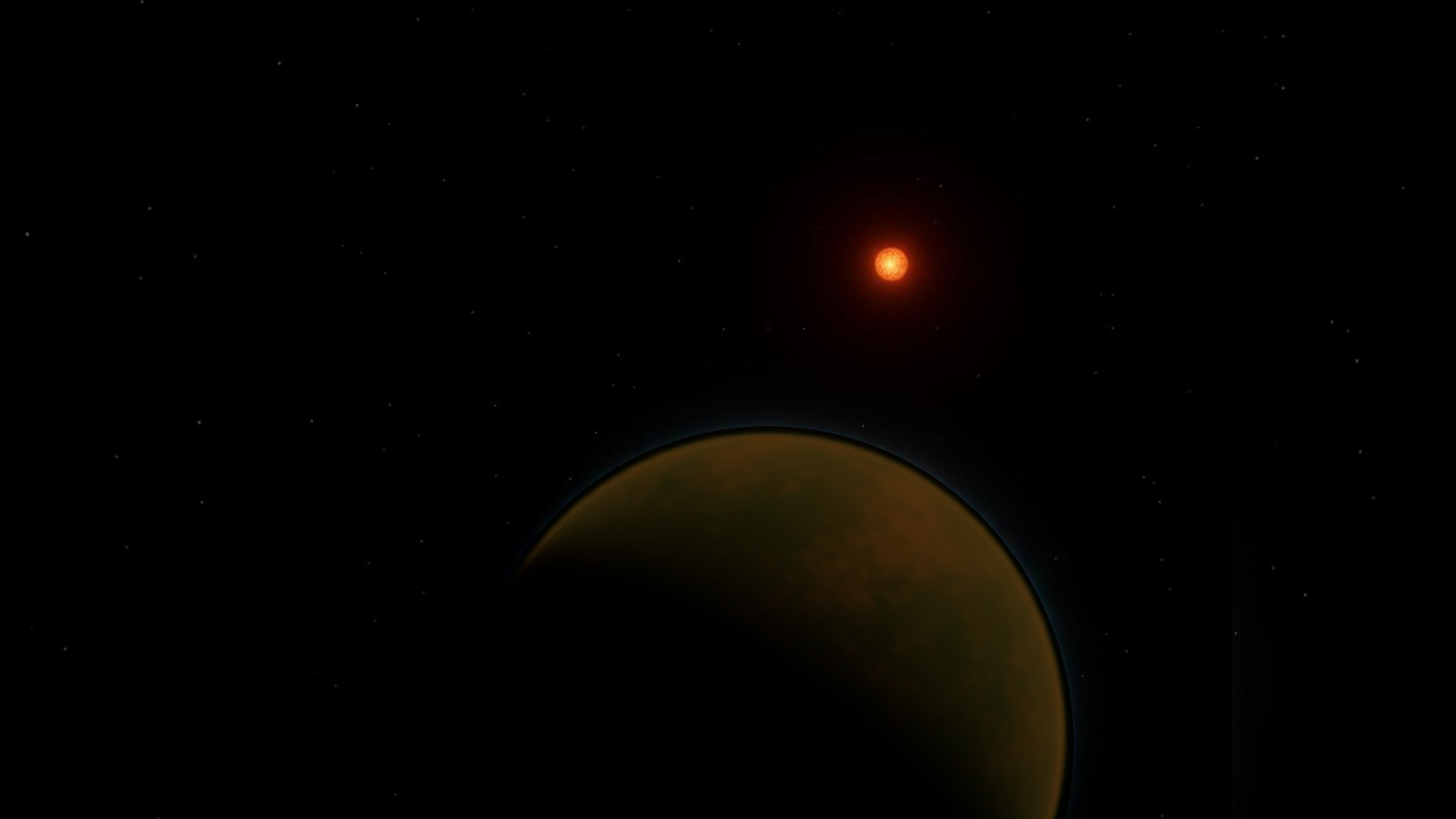

Ecco come potrebbe apparire un ambiente tipico nei pressi del terminatore di GJ 251c in una bella giornata di sole, pardon, Gliese 251.

Una plausibile composizione potrebbe essere simile a quella terrestre dell’Eone Adeano. Quindi ipotizziamo:

-

Atmosfera:

-

Pressione: \( 3.0 \ \text{bar} \)

-

CO₂: \( 75\% \) → \( 2.25 \ \text{bar} \)

-

N₂: \( 20\% \) → \( 0.6 \ \text{bar} \)

-

CH₄: \( 4\% \) → \( 0.12 \ \text{bar} \)

-

H₂: \( 1\% \) → \( 0.03 \ \text{bar} \)

-

-

Temperature:

-

Emisfero diurno: \( 290-310 \ K \)

-

Terminatore: \( 273-283 \ K \)

-

Emisfero notturno: \( 200-230 \ K \)

-

Con una pressione sufficiente a garantire il rimescolamento atmosferico su entrambi gli emisferi di un pianeta marealmente bloccato:

\[

P_{atm} \approx 2 – 4 \, \text{bar}

\]

e una temperatura media di superficie vicina al punto triplo dell’acqua:

\[

T_{surf} = T_{eq} + \Delta T_{serra} \Rightarrow T_{surf} \approx 276 \, \text{K}

\]

Profilo di assorbimento dei pigmenti:

\[

A(\lambda) = A_0 \cdot e^{-\left( \frac{\lambda – \lambda_{peak}}{\sigma} \right)^2}

\]

\[

\lambda_{peak} \approx 1.1 \, \mu m

\]

Biosfera ipotetica: licheni infrarossi

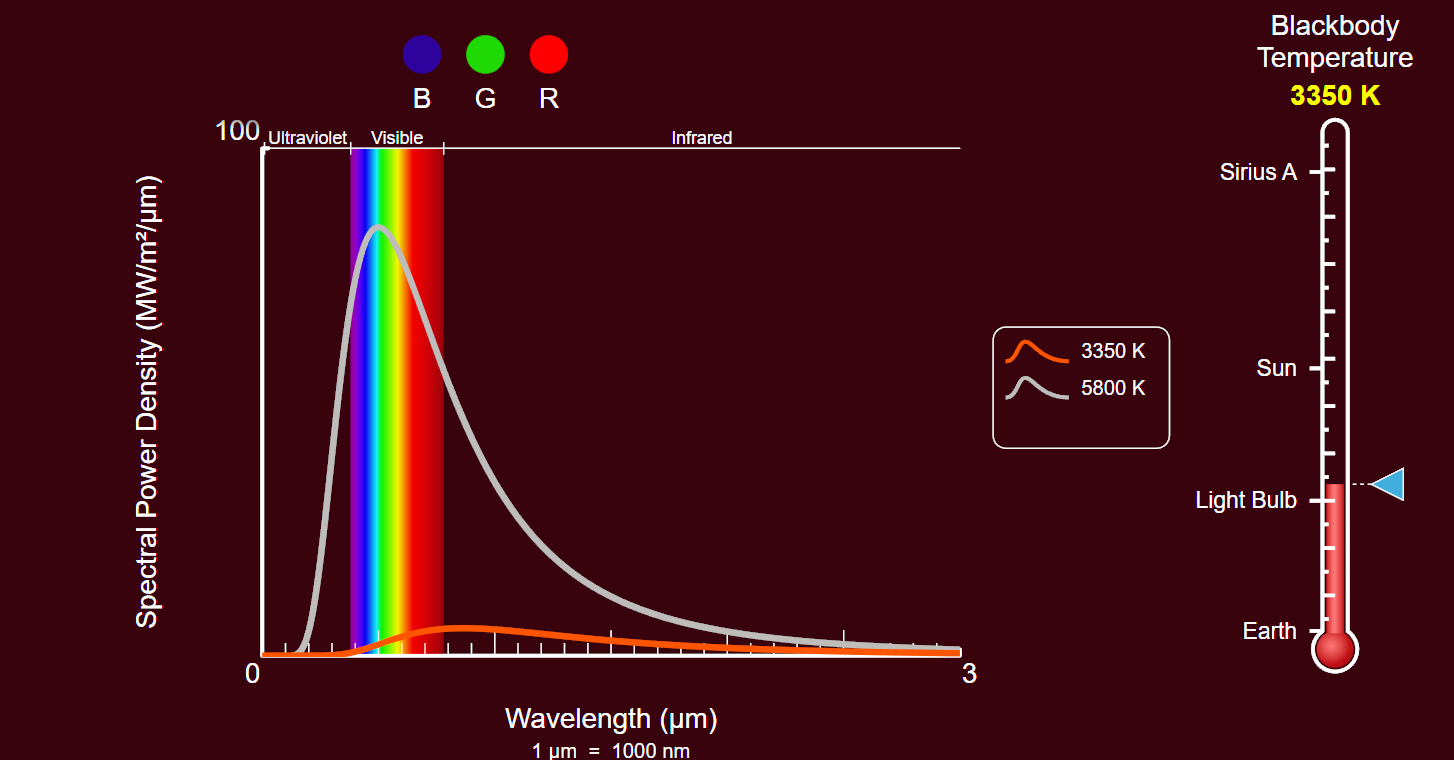

Comparazione della radiazione di corpo nero tra Gliese 251 (in rosso) e il Sole (grigio). Lo sfondo potrebbe somigliare a quello che gli occhi umani percepirebbero in una bella giornata a mezzogiorno.

Tutto quanto finora detto con la matematica ha una notevole importanza per lo sviluppo di possibili forme di vita su Gliese 251c. Facciamo altri due conti:

La legge di Wien che descrive la radiazione di corpo nero per \(T\) è:

\[

\lambda_{\text{max}} = \frac{2.898 \times 10^{-3}}{T}

\]

Per \( T = 3350 \, \text{K} \), otteniamo: \(

\lambda_{\text{max}} \approx 865 \, \text{nm}

\), ma abbiamo visto che una atmosfera abbastanza dinamica da agire su entrambi gli emisferi di un pianeta bloccato spinge ancor di più verso il lontano infrarosso il picco di radiazioni: \(

\lambda_{peak} \approx 1100 \, \text{nm}\)

Questo ci suggerisce che su Gliese 251c potremmo aspettarci forme di vita anaerobica, dotate di metabolismo lento e pigmenti scuri, simili alla rodopsina terrestre [3] presente in alcuni funghi chitridiomiceti [4].

Questi organismi potrebbero sfruttare meccanismi di conversione energetica analoghi all’ATP sintasi, l’enzima che immagazzina energia luminosa sfruttando un gradiente elettrochimico nei mitocondri degli eucarioti e nella membrana cellulare dei procarioti.

Il loro habitat ideale potrebbe essere costituito da rocce porose nella zona crepuscolare, dove la luce visibile è scarsa e il vicino infrarosso (NIR) domina. Mentre sulla Terra pigmenti come la rodopsina assorbono nel NIR—una lunghezza d’onda invisibile all’occhio umano—appaiono del tutto incolori 3, in un mondo dove ogni fotone è prezioso, l’evoluzione spingerebbe gli organismi ad adattare i propri enzimi fotosensibili per massimizzare l’assorbimento dell’energia disponibile, spostata verso le lunghezze d’onda rosse e infrarosse.

Dovremmo quindi aspettarci di trovare pigmenti capaci di assorbire uno spettro molto più ampio, ce va dalla parte più alta dello spettro visibile su quel mondo fino alla luce infrarossa dominante. Questi pigmenti assorbirebbero tutta la luce visibile (per quanto scarsa) e quella infrarossa, apparendo neri ai nostri occhi.

Il ciclo biochimico che dovremmo quindi aspettarci di trovare è pressapoco questo:

\[ 4H_2 + CO_2 \rightarrow CH_4 + 2H_2O + \text{energia} \]

Conclusione

Gliese 251c non è una seconda Terra. È un mondo alieno, forse abitabile per quelle forme di vita che metabolizzano nell’infrarosso e respirano metano. Considerando che Gliese 251 ha un’età di 6.8 miliardi di anni – è più vecchia del Sole – il pianeta ha avuto abbondante tempo non solo per sincronizzarsi con la sua stella, ma anche per sviluppare una biosfera matura e stabilizzare la sua atmosfera

Forse, sul pianeta potrebbero coesistere anche sacche di vita con biochimiche molto diverse tra loro la cui unica cosa in comune è la fioca luce della loro stella.

E proprio per questo, è ancora più affascinante.