Da Roswell all’Area 51

Un aerostato del Progetto Mogul in fase di allestimento precedente al volo. I volti dei tecnici sono stati oscurati per nascondere la loro identità.

Credit: USAF/CIA, 1997

L’ambiente sociale in cui scoppiò il fenomeno UFO era molto particolare. Da un lato gli Stati Uniti avevano vinto una guerra mondiale contro un nemico, almeno inizialmente, tecnologicamente più avanzato. La paura per una rappresaglia nazista era ancora ben viva nella mente degli americani. Ma appena finita la guerra col Giappone grazie a due bombe atomiche, ecco affacciarsi un nuovo e più temuto nemico che fino al giorno prima era stato suo alleato durante la guerra: l’Unione Sovietica.

La fobia per i sovietici spinse gli USA come mai era accaduto nella loro storia a finanziare la ricerca, sia civile che, soprattutto, militare. Nel 1947 il timore che i russi sviluppassero armi atomiche in grado di colpire il suolo americano spinse gli americani a progettare una rete di fonometri ad alta quota per monitorarne i progressi. Tale progetto fu affidato all’università di New York che, basandosi sul concetto che le onde acustiche di una sonora esplosione possono raggiungere l’alta atmosfera ed essere captabili quindi oltre il raggio della curvatura terrestre. Il nome di quell’operazione era Mogul [1].

Tale programma in verità ebbe vita assai breve: troppo costoso e assai poco affidabile.

Operazione Mogul

Nella pratica l’intera operazione consisteva nell’inviare nell’atmosfera superiore tutta una serie di palloni aerostatici che sorreggevano i microfoni con la relativa elettronica. Per i primi test di lancio fu impiegata una boa marina e riflettori ottaedrici per monitorare la posizione delle sonde al posto dei più classici sistemi di triangolazione del radiosegnale (Non c’era posto in aereo per portare i ricevitori!).

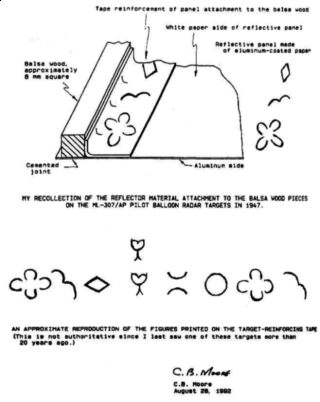

Il radar del sito di lancio ([fancybox url=”https://www.google.com/maps/place/Holloman+AFB,+NM+88330/@32.8431167,-106.1366451,13z/data=!3m1!4b1!4m13!1m7!3m6!1s0x0:0x0!2zMzTCsDE1JzAyLjAiTiAxMDXCsDM1JzQ0LjAiVw!3b1!8m2!3d34.250556!4d-105.595556!3m4!1s0x86e05c343376eabd:0xaed4091d6eaea12f!8m2!3d32.8438274!4d-106.0990906?hl=en”]Holloman Air Force Base, Alamogordo, New Mexico[/fancybox]) non riusciva infatti a seguire efficacemente il pallone sonda fatto di neoprene — un materiale con una resa molto migliore della comune gomma per i palloni stratosferici, oggi di uso comune per esempio nelle tute da sub (è difficile da tagliare o strappare e torna sempre nella sua forma originale …) ma piuttosto innovativo nel 1947 — e per questo i tecnici fecero ricorso all’ultimo momento ai riflettori radar, commissionandoli a una fabbrica di giocattoli, che usò lo stesso nastro adesivo rosa e viola con motivi fantasia, usato dall’azienda per alcuni loro giocattoli, per rinforzare la balsa usata per costruire i riflettori ottaedrici, del resto molto simili agli aquiloni per bambini.

La sonda n°4 del progetto Mogul partì dalla base aerea di Holloman il 4 di giugno. Come ho cercato di spiegare, le sonde erano ancora nella fase sperimentale, quasi tutto il materiale necessario alla loro costruzione proveniva dal libero mercato, anche il fonorivelatore era una banale boa d’ascolto marina, una AN/CRT-1 [2] [3].

Tutto l’impianto della sonda era quindi sperimentale: 20 palloncini collegati in cordata alla distanza di 6 metri l’uno dall’altro (le sonde meteo usavano soltanto un palloncino da 350 grammi), 5 riflettori ottaedrici fatti con carta stagnola (probabilmente una versione del Mylar conosciuto come Terylene, noto anche come PET) e balsa e una boa marina lanciati nell’atmosfera superiore; la storia di copertura della solita sonda meteorologica non avrebbe retto neanche un minuto in caso di incidente.

Una notte buia e tempestosa

|

[A] large area of bright wreckage made up of rubber strips, tinfoil, a rather tough paper and sticks. [Una] grande area di brillanti detriti, composti da strisce di gomma, da stagnola, da carta e bastoncini. There was no sign of any metal in the area which might have been used for an engine and no sign of any propellers of any kind, although at least one paper fin had been glued onto some of the tinfoil. Non trovammo alcun segno di metallo nella zona che potesse sembrare un motore o qualcosa di simile, anche se c’era un’aletta di carta che aveva incollati alcuni [pezzi] di carta stagnola. There were no words to be found anywhere on the instrument, although there were letters on some of the parts. Considerable scotch tape and some tape with flowers printed upon it had been used in the construction. Non trovammo alcuna parola [o scritta] sull’oggetto, sebbene ci fossero delle lettere su alcuni pezzi. Molto nastro adesivo e qualche nastro con fiori stampati erano stati utilizzati nella costruzione. No strings or wire were to be found but there were some eyelets in the paper to indicate that some sort of attachment may have been used. Nessuna stringa o filo furono trovati ma c’erano alcuni occhielli nella carta che suggerivano che un qualche tipo di legatura potrebbe essere stata utilizzata. William “Mac” Brazel |

Ed è quello che avvenne il 7 luglio 1947, o uno dei giorni immediatamente precedenti secondo alcune fonti, vicino a [fancybox url=”https://www.google.com/maps/place/33%C2%B058’06.0%22N+105%C2%B014’36.0%22W/@34.1680175,-106.1775067,8.61z/data=!4m5!3m4!1s0x0:0x0!8m2!3d33.968333!4d-105.243333?hl=en”]Roswell, New Mexico[/fancybox], dopo un volo di 145 chilometri dal sito di lancio. Un temporale fece precipitare la sonda Mogul n° 4 senza controllo in un ranch dove poi fu trovata da William Brazel, il rancher della contea di Lincoln che scoprì il relitto (alcune frasi della sua testimonianza sono riportate qui a fianco).

Nulla nel luogo dell’incidente poteva far credere a uno schianto di un disco volante; anche la cordata di palloni era volata via da qualche altra parte mentre quello che fu trovato sul primo sito erano i resti, stando alla prima testimonianza del rancher, che potevano appartenere a qualcuno dei cinque riflettori — in effetti racconta Brazel che tentarono inutilmente di ricomporre quello che pensavano essere un aquilone — e qualche pezzo di neoprene translucido di qualche palloncino distrutto, forse dalla tempesta o forse dalla caduta.

Il resto è una storia che finì lì. Per un paio di settimane i giornali locali dettero spazio alla notizia e anche qualche agenzia internazionale lo fece, come la [fancybox url=”https://ilpoliedrico.com/wp-content/uploads/2017/07/afp9jul1947.jpg”]France Press.[/fancybox]

Comunque, già nel 1952 si era scoperto che i rottami di Roswell erano i resti di un qualche bersaglio radar [4] quasi certamente appartenuto a qualche tipo di progetto militare segreto.

Erano trascorse soltanto un paio di settimane dal curioso racconto di Kenneth Arnold [5] e stava diventando assai comune e sarcastico descrivere tutto ciò che non si poteva riconoscere in cielo con un lapidario “They’re a flying saucers“, un po’ come oggi usiamo ironicamente dire “Sono degli UFO” [1.

Tuttavia poi l’ilarità suscitata da questo argomento portò nel 1950 a Los Alamos durante una pausa pranzo Enrico Fermi a chiedersi: “ Where’s Everybody?“] [6].

Trent’anni di silenzio

Comunque fu nel 1978 che la storia di Roswell riprese vigore. Nel paragrafo XVIII di Retrievals of the Third Kind: A case study of alleged UFOs and occupants in military custody [7], il saggista e ricercatore UFO Leonard Stringfield 1 racconta di essere stato contattato da un maggiore dell’Intelligence dell’Air Force , J.M. (Jesse Marcel) che disse di aver partecipato al recupero dei resti di Roswell.

|

Major J.M. and aides were dispatched to the area for investigation. There he found many metal fragments and what appeared to be “parchment” strewn in a 1 square mile area. “The metal fragments,” said the Major, “varied in size up to 6 inches in length, but were of the thickness of tinfoil. The fragments were unusual,” he continued, “because they were of great strength. They could not be bent or broken, no matter what pressure we applied by hand. The area was thoroughly checked, he said, but no fresh impact depressions in the sand were found. The area was not radioactive. The fragments, he added, were transported by a military carry-all to the air base in Roswell and from that point he was instructed by General Ramey to deliver the “hardware” to Ft. Worth, to be forwarded to Wright-Patterson Field for analysis. When the press learned of this retrieval operation, and wanted a story, Major J.M. stated, “To get them off my back I told them we were recovering a downed weather balloon.” When the major was asked for his opinion as to the identification of the fragments he was certain they were not from a balloon, aircraft, or rocket. He said because of his technical background he was certain that the metal and “parchment” were not a part of any military aerial device known at that time. [Il] Maggiore J.M. e i suoi assistenti furono inviati nella zona per l’inchiesta. Lì trovarono molti frammenti di metallo e quella che sembrava essere “pergamena” sparsi in un’area di un miglio quadrato. Leonard H. Stringfield |

Il testimone, J. M., affermò di aver raccolto dal luogo dello schianto dei frammenti di una specie di carta stagnola non più grandi di 15 centimetri, però molto resistenti alla trazione e alla piegatura, tutte caratteristiche del polietilene tereftalato, inventato nel 1941 in Inghilterra col nome di Terylene e brevettato come Mylar nel 1952.

Se effettivamente i riflettori radar fossero stati costruiti con tessuto di polietilene come il Terylene, non ci sarebbe niente di anomalo o di alieno nei resti raccolti dai militari guidati dal maggiore J. M.. Esso era soltanto un materiale inventato pochi anni prima e ancora sconosciuto al pubblico e il suo impiego in un pallone meteo sarebbe sembrato troppo curioso.

Nessuna radioattività, nessun altro cratere da impatto, nessun congegno che possa somigliare a un motore o propulsore. Niente di niente, nessuna prova che una navicella extraterrestre si sia mai schiantata a Roswell quel giorno.

Ma la fantasia dei fuffologi (io scherzosamente li chiamo così, non posso neanche immaginare che le storie da essi raccontate siano anche solo lontanamente verosimili e che possano crederci veramente anche loro) non finisce certo qui, con l’ufino che dopo un viaggio di ben 39.2 anni luce — sì, perché i ‘lieni pensati dai fuffologi vengono da ζ Reticuli! — va a schiantarsi nel bel mezzo del nulla come un autista ubriaco.

Tale nave spaziale, prelevata dai militari, sarebbe stata impacchettata e spedita presso una base militare talmente segreta che non ne esisterebbe traccia neppure negli archivi militari.

Area 51

Tale base è la famigerata Area 51. Qui secondo la mitologia ufologica la nave spaziale sarebbe stata smontata, studiata e riprodotta.

Quei fanatici sono convinti che sia stata l’ingegneria inversa applicata sulla tecnologia dell”UFO a darci oggi i componenti elettronici miniaturizzati, i microchip che controllano anche la nostra lavatrice, i cristalli liquidi delle nostre TV e le altre mille diavolerie moderne. Nulla riguardo a nuovi sistemi di energia e propulsione, su come affrontare i viaggi interstellari o come risolvere i nostri, gravi, problemi di inquinamento che minacciano la nostra specie di più di quanto faccia l’intero arsenale nucleare globale!

Non contenti, questi pittoreschi narratori, hanno aggiunto in seguito ‘lieni morti o moribondi, biopsie segrete sui cadaveri dei suddetti, contatti con specie extraterrestri e alleanze o collaborazioni di comodo occulte, perfino.

Al di la di tutte queste idiozie, la super segreta Area 51 esiste davvero. Non è poi così segreta anche se i vertici militari USA ne celarono l’esistenza fino al 2013.

Anche i programmi svolti in questa base erano talmente segreti e compartimentati che gli stessi ingegneri non avevano coscienza del loro lavoro o di quello dei loro colleghi 3.

L’area in cui sorge la base, i resti di un lago salato ormai asciutto, Groom Lake, è piuttosto lontana da qualsiasi insediamento civile e è un’ottima pista naturale per il collaudo di aerei. Per questo è un sito militare di enorme importanza strategica.

Qui furono sviluppati e testati aerei militari super segreti: il Progetto Acquatone, che portò al primo aereo stratosferico Lockheed U-2, il cui scopo era proprio quello di spiare dall’alto i progressi militari sovietici, nacque proprio qui. Nel 1960 però un missile contraereo russo riuscì ad abbattere uno di questi [8].

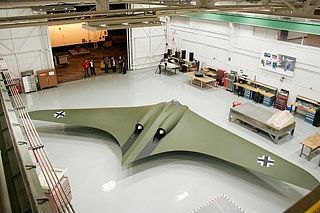

Questo incidente causò un ripensamento generale dell’intero progetto, anche se è importante sottolineare che l’U-2, essendo ancora in servizio, resta uno dei velivoli più longevi della storia militare. Così nacque il Progetto Oxcart, che portò alla realizzazione di un nuovo velivolo con capacità supersonica (Mach 3.35) a quota di crociera (23000 metri), il Lockheed A-12. In confronto l’U-2 era quattro volte e mezza più lento 4. L’aereo poteva volare a oltre tre volte la velocità del suono a quote che erano il triplo dei normali aerei di linea di quel tempo, e alcune sue configurazioni non erano verniciate. In sostanza erano interamente lucide tanto da poter riflettere i raggi del sole ed essere visto anche dal suolo. La particolare forma era stata studiata per eliminare gli angoli retti per aver la più piccola impronta radar possibile e questo lo rendeva il velivolo più bizzarro che si fosse visto a quell’epoca. Però presto l’A-12 si rivelò essere un aereo costosissimo e tutto quel calore in eccesso lo rendeva un ottimo bersaglio per i missili a guida termica. Fu così che nacque l’idea di progettare i primi velivoli avanzati con tecnologia stealth come il Lockeed SR-71 Blackbird.

Non voglio qui ripercorrere tutti i progetti ormai non più segreti di tutte le tecnologie nate nell’Area 51. Ma dal gigantesco U-2 al costosissimo A-12, fino ai moderni bombardieri B-2 e altri aerei dalle forme più strane e improbabili, dalla fine della Seconda Guerra Mondiale con i prototipi del bombardiere Northrop YB-35 (primo volo nel 1946) che riprendevano il concetto del Horten HO-229 nazista, poi nella versione a turbogetto YB-49 dell’anno dopo — curiosamente simile alle descrizioni dei flying saucers di Kenneth Arnold, negli Stati Uniti è stato un gran fiorire di prototipi di velivoli segreti che a occhi non preparati venivano descritti come UFO. Si calcola che almeno la metà di tutti i presunti avvistamenti UFO negli anni ’50 e ’60 siano da imputarsi a velivoli sperimentali segreti, alcuni dei quali li abbiamo visti entrare in servizio attivo mentre altri sono finiti nel dimenticatoio, abbandonati o cancellati.

Guardate la carrellata di alcuni aerei qui sotto, in attesa del gran finale …

[/fancybox]

[/fancybox]

[/fancybox]

[/fancybox]

[/fancybox]

[/fancybox]

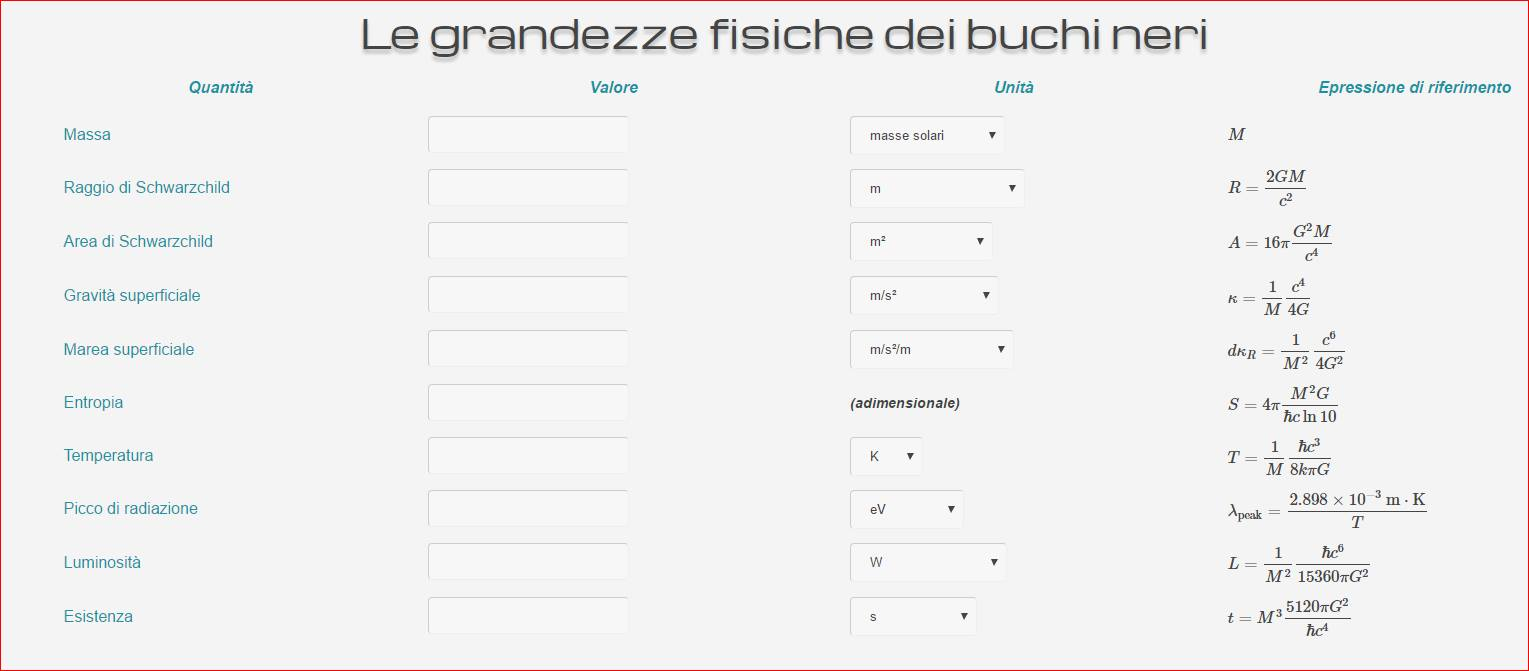

[/fancybox]Cliccando sull’immagine qui sopra vi si aprirà una finestra su cui potete sbizzarrirvi a studiare alcune delle bizzarre proprietà matematiche dei buchi neri.

[/fancybox]Cliccando sull’immagine qui sopra vi si aprirà una finestra su cui potete sbizzarrirvi a studiare alcune delle bizzarre proprietà matematiche dei buchi neri.

[/fancybox]

[/fancybox]