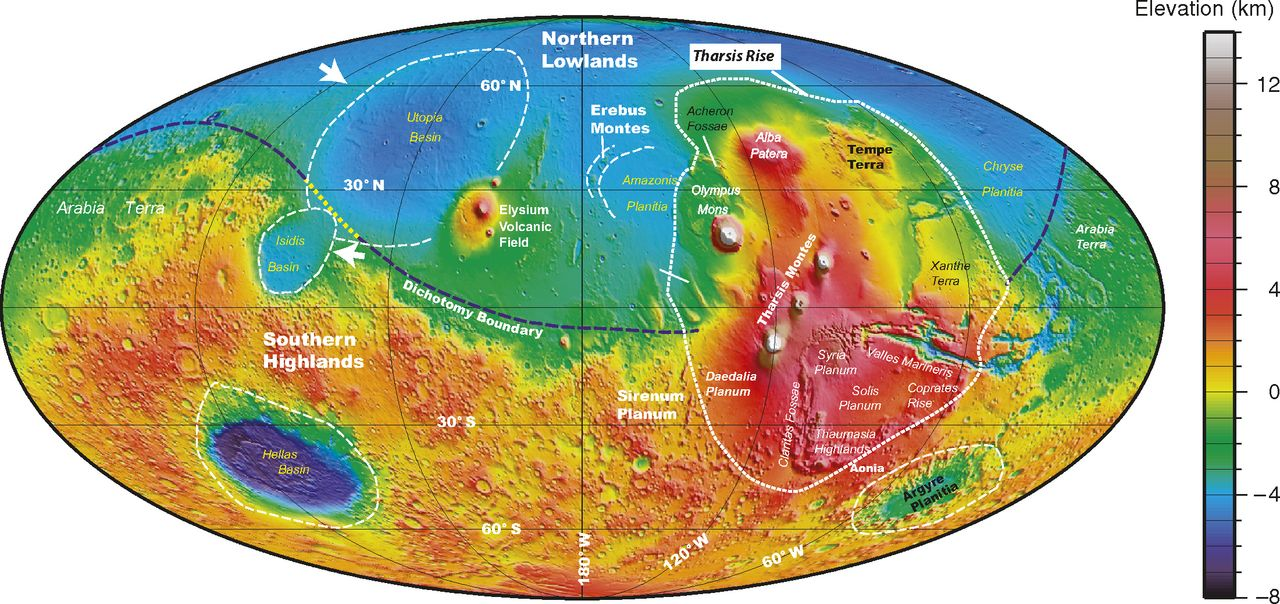

Riprendo qui un argomento di cui avevo iniziato a parlare a dicembre [1] riguardo all’Intenso Bombardamento Tardivo e la curiosa Dicotomia Marziana. La scoperta di un asteroide ricco di carbonio, \(2004 EW_{95}\), nella Fascia di Kuiper potrebbe essere la “pistola fumante” del Grand Tack, la Grande Virata.

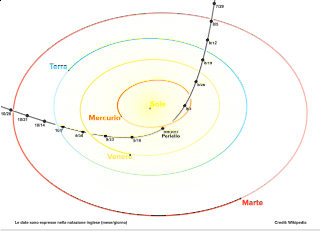

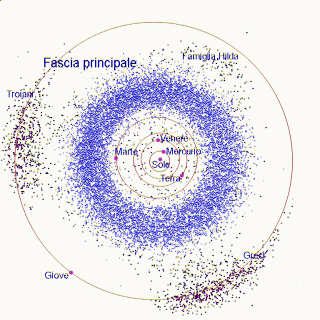

La linea rossa in questa immagine mostra l’orbita dell’asteroide 2004 EW 95 nella Fascia di Kuiper , in verde invece sono mostrate le orbite di altri corpi del Sistema Solare .

Credit: ESO / L. Calçada

Se da un lato la scoperta di altri sistemi planetari in orbita a altre stelle ci ha permesso di comprendere definitivamente che il nostro sistema solare non è una eccezione nel cosmo, dall’altro ci mostra che questo comunque possiede qualcosa di precipuo: la sua struttura. Una recentissima indagine sui sistemi multiplanetari scoperti da Kepler [cite]https://arxiv.org/abs/1706.06204[/cite] sottolinea questa peculiarità: la stragrande maggioranza dei sistemi sinora scoperti possiede ‘grappoli’ di pianeti, ossia una sfilza di pianeti con caratteristiche e distanze piuttosto simili fra loro. In altre parole, se una stella possiede un pianeta di taglia terrestre, i precedenti e i successivi non sono poi così dissimili, e la stessa osservazione pare valere per una stella che abbia pianeti di stazza gioviana: anche in questo caso gli altri pianeti di quel sistema appaiono piuttosto simili.

Al contrario invece, la taglia dei pianeti del Sistema Solare è piuttosto disomogenea.

Giove errante

Questo diagramma mostra la distribuzione orbitale in scala logaritmica dei pianeti extrasolari più piccoli di Giove che sono stati rilevati dalla missione di Keplero, in confronto alle orbite di Mercurio, Venere, Terra e Marte. La maggior parte di questi pianeti extrasolari sono molto più vicini alle loro stelle di accoglienza di quanto non lo siano i pianeti più interni del nostro Sistema Solare. Credit: Batygin e Laughlin, PNAS

L’idea che un giovane Giove errante possa essere stato il grande protagonista della storia dei primordi del Sistema Solare risponde ai tanti quesiti ancora irrisolti sulle sue tante peculiarità.

Questa nuova teoria si deve a Konstantin Batygin , uno scienziato planetario del Caltech, e Gregory Laughlin dell’UC Santa Cruz [2].

Qui si propone che il Pianeta Gigante si sia formato fra 3 e le 5 U.A. dal Sole mentre il Sistema Solare interno si stava popolando di oggetti anche più grandi della Terra stessa. Man mano che la sua massa diventava sempre più importante, la viscosità della nebulosa interplanetaria ancora presente lungo la sua orbita l’avrebbe rallentato spingendolo verso il Sole in orbite via via più piccole 1. Tale decadimento avrebbe spinto Giove fino a una distanza di circa 1,5 U.A. dal Sole, perturbando così le orbite di tutti gli altri pianeti interni e spingendo su altrettante orbite fortemente ellittiche tutti i planetesimi che perturbava.

Intanto un altro corpo celeste si stava formando poco più indietro, e a lui si deve la nostra fortuna: Saturno. Il secondo corpo massiccio in formazione poco dietro il primo Giove entrò presto in risonanza orbitale 2:1 con questo: due orbite del primevo Giove corrispondevano a una singola orbita di Saturno.

Tale risonanza ebbe l’effetto di riaccelerare Giove e di trainarlo di nuovo verso le 5 U.A. nell’arco di 100 mila anni e di spingere Saturno oltre le 7 U.A.: un po’ come la piroetta che si dà un lanciatore del martello in atletica. Giove riacquistò così abbastanza velocità orbitale e momento angolare a scapito di Saturno e insieme la coppia dei pianeti giganti si stabilì dove più o meno sono oggi, dove la risonanza si è interrotta. In seguito poi Saturno si sarebbe stabilizzato attorno alle 9 U.A.

L’incursione di Giove nel Sistema Solare interno ebbe alcuni importanti effetti: quando vi entrò destabilizzò le orbite dei planetoidi — alcuni probabilmente erano anche più grandi della Terra — che si erano già formati spingendoli verso il Sole e quando vi uscì portò via con sé un bel po’ di materiale asteroidale che avrebbe poi creato la Fascia Principale di asteroidi e quelli che orbitano intorno ai punti lagrangiani della sua orbita. Il risultato fu un sistema interno talmente povero di materiale che ce ne fu appena per formare Venere e Terra. Altri corpi minori del Sistema Solare interno, come \(2004 EW_{95}\)[cite]https://arxiv.org/abs/1801.10163[/cite] furono espulsi fino alla Fascia di Kuiper [3].

L’incursione di Giove nel Sistema Solare interno ebbe alcuni importanti effetti: quando vi entrò destabilizzò le orbite dei planetoidi — alcuni probabilmente erano anche più grandi della Terra — che si erano già formati spingendoli verso il Sole e quando vi uscì portò via con sé un bel po’ di materiale asteroidale che avrebbe poi creato la Fascia Principale di asteroidi e quelli che orbitano intorno ai punti lagrangiani della sua orbita. Il risultato fu un sistema interno talmente povero di materiale che ce ne fu appena per formare Venere e Terra. Altri corpi minori del Sistema Solare interno, come \(2004 EW_{95}\)[cite]https://arxiv.org/abs/1801.10163[/cite] furono espulsi fino alla Fascia di Kuiper [3].

Inoltre, con l’uscita dell’influenza di Giove del Sistema Solare interno non restò neppure abbastanza materiale per la crescita di Marte (avendo Marte un’orbita assai più grande della Terra avrebbe dovuto raccogliere molto più materiale di questa e di conseguenza essere anche più grande) e gli altri piccoli corpi in orbite fortemente ellittiche non ancora caduti sul Sole finirono per alimentare l’Intenso Bombardamento Tardivo di 3.9 miliardi di anni fa e le cui tracce si scoprono oggi sulla Luna.

No, ai suoi albori il Sistema Solare non era quel luogo tranquillo come lo è oggi, con pianeti su orbite stabili e quasi circolari per i pianeti più grandi. A causa di Giove e Saturno i primi milioni di anni furono tremendi ma è anche grazie a questi se oggi viviamo in un sistema planetario relativamente tranquillo e sicuro. Oggetti come \(2004 EW_{95}\) potrebbero raccontarci molto su ciò che era in quella remota era il Sistema Solare, come è nato,m la sua composizione e forse anche come è nata la vita qui sulla Terra. Sarebbe bello poter esplorare in futuro questi corpi, hanno ancora tanto da dirci!