Sono stato indeciso fino all’ultimo se scrivere questo post o meno; e passato molto tempo da quando parlavo di politica su queste pagine. Ma adesso credo che il momento sia maturo per affrontare l’importante argomento politico del Partito del NO a tutto; un partito abbastanza trasversale (da destra a sinistra, dagli accademici più premiati ai più fessi che si possono incontrare un po’ in ogni dove).

Purtroppo la corruzione endemica di questo paese ha impedito che in più di cinquant’anni non si completassero 500 chilometri di autostrada, dove i piloni stradali crollano per l’inconsistenza dei materiali usati eppure pagati 10 volte tanto quanto ne costerebbe uno buono. Fareste costruire una centrale nucleare, una piattaforma estrattiva o una semplice galleria (guardate in proposito il valico tra Toscana ed Emilia …) a costoro?

A volte dire no in questo paese anche se forse non sembra la scelta più logica da fare, inevitabilmente si rivela col senno del poi quella più giusta.

Aggiornamento: lo studio sui costi della linea ad alta velocità Torino -Lione della Corte dei Conti francese del 2012 non è più disponibile sul sito originale ma ne esiste una copia su web.archive.org.

Un detto abbastanza comune nel mondo anglosassone “Not in my back yard!” almeno in Italia pare riscuotere molto successo. Il perché di questo è presto detto: negli ultimi anni molti comitati cittadini si sono costituiti per dire NO a tante opere e infrastrutture volute spesso imposte come necessarie ed emergenziali da un certo modo, spesso sordo e non lungimirante, di fare politica.

Un detto abbastanza comune nel mondo anglosassone “Not in my back yard!” almeno in Italia pare riscuotere molto successo. Il perché di questo è presto detto: negli ultimi anni molti comitati cittadini si sono costituiti per dire NO a tante opere e infrastrutture volute spesso imposte come necessarie ed emergenziali da un certo modo, spesso sordo e non lungimirante, di fare politica.

Ma se fino agli anni ’90 del XX secolo la notizia dell’esistenza di molti di questi comitati cittadini spesso non varcava neppure i confini della propria provincia, con l’avvento della comunicazione democratica di Internet, la notorietà di questi comitati è – giustamente – esplosa. Si possono condividere o meno le ragioni di questi comitati, ma è giusto e anche democratico scoprirne l’esistenza e conoscere i motivi della loro battaglia.

Qualche volta il valore di queste battaglie è stato usato anche a sproposito o per fini di visibilità, onorificenze e carriere politiche, ad esempio.

NO-NUKE

Prendiamo ad esempio i due referendum sull’uso dello sfruttamento a scopo civile dell’energia nucleare. Il primo, del maggio 1986, sull’onda emotiva del disastro di Chernobyl gli italiani scelsero di abbandonare quel settore, nonostante che fosse ben evidente che la centrale nucleare sovietica era ben più pericolosa di una italiana: diversi i sistemi di raffreddamento del nocciolo combustibile e gli scopi per cui era stata creata. Uno di quei promotori di quel NO al nucleare vent’anni dopo, due legislature politiche e incarichi altrettanto prestigiosi, decise che era giunto il momento per l’Italia di riconsiderare le proprie scelte energetiche e, da buon lobbista, questa volta si schierò per il ritorno del nucleare in Italia.

Si dice che è prerogativa unica degli stolti quella di non cambiare mai idea, e infatti, non mi vergogno affatto a dirlo, nel 1986 infatti votai per l’uso civile dell’energia nucleare in Italia perché non esistevano ancora alternative economicamente più vantaggiose all’uso dei combustibili fossili.

Quello che negli anni mi ha spinto a riconsiderare la mia posizione non è legata al mio percorso scientifico, politico e formativo, quanto piuttosto alle mutate condizioni socio-economiche del nostro Belpaese.

In primis le condizioni economiche e la tecnologia per lo sfruttamento delle tecnologie rinnovabili hanno reso virtualmente improponibile una riproposizione dell’energia nucleare in questo paese. Un centrale elettronucleare ha una vita tutto sommato breve a fronte dei suoi ingenti costi di realizzazione e gestione. Adesso non siamo nella situazione molto più rosea per i conti pubblici degli anni ’90. Con un debito pubblico così alto gli incentivi economici necessari al recupero della somma investita sarebbero improponibili, scaricando così i costi su tutta la collettività, mentre invece un investimento serio su un piano di rientro energetico a lungo termine basato sulle fonti rinnovabili sarebbe molto più economico, al di là delle solite bischerate raccontate sui costi indotti di queste.

Poi c’è l’aspetto secondo me ben più importante, anche se sembra di parte: la corruzione che parte dal piccolo “Lei non sa chi sono io!” fino ai vertici politici di questo Paese che non ha abbastanza memoria per ricordare i suoi macroscopici errori, come ad esempio – e perdonatemi se parto da lontano – gli infiniti errori nella pianificazione e nella costruzione della diga del Vajont, ma anche dei piloni dei cavalcavia che crollano prima – per fortuna – dell’inaugurazione delle strade, dei controsoffitti in materiale scadente di molti edifici scolastici, delle case della New Town del dopo terremoto dell’Aquila. Fareste costruire una centrale nucleare a chi lucra sulla bontà dei materiali una centrale elettronucleare anche se questa sulla carta fosse la più sicura del mondo? Io credo proprio di no, e principalmente per questi due motivi nel 2011 mi sono apertamente schierato per dire NO al ritorno del nucleare in Italia.

Ma se il mio NO al nucleare non vi sembra supportato da buoni motivi, esiste anche il mio NO alla linea ad alta velocità in Val di Susa.

NO-TAV

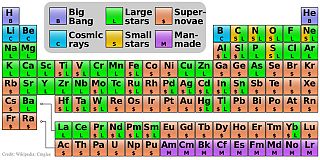

Rapporto Alpinfo 2010 – Andamento 1980-2010 dei traffici ferroviari e stradali attraverso le Alpi.

Credit Wikipedia

Il progetto della ferrovia Torino-Lione nasce in un contesto di viabilità europea sviluppato tra gli anni ’90 e il 2000. Il mastodontico progetto da 23 miliardi di euro nacque in un quadro economico precedente alla crisi economica del 2008 e dal quale l’Italia, ben lungi dai canti di sirena dei vari governi che si sono succeduti nel frattempo, non è mai risorta. Qui valgono le stesse motivazioni economiche del quadro precedente e dico che essa è troppo costosa per potercela permettere. Inoltre proprio li vicino esiste già un’altro tracciato ferroviario molto simile: quello del Frejus. Questo tracciato, che già collega la Francia con l’Italia nacque nel XIX secolo ma durante tutto il ‘900 e il decennio appena trascorso è stato più volte aggiornato agli standard dell’epoca. L’ultima opera di ammodernamento risale al periodo 2003-2011 per un costo complessivo ufficiale di 108 milioni di euro (alcune voci parlano che in realtà il costo finale sia stato intorno ai 400 e non stento a crederlo) ma che per colpa dei francesi che volevano risparmiare dalla loro parte l’opera in realtà è riuscita zoppa, facendo così di conseguenza lievitare i costi di manutenzione della tratta [cite]http://www.mit.gov.it/mit/mop_all.php?p_id=11149[/cite].

Nel frattempo l’ipotesi che rendeva apparentemente spendibile il tratto Torino-Lione, lo scambio merci principalmente tra i due paesi in un più vasto quadro di collegamenti europei, veniva meno quando già diversi rapporti internazionali indicavano in realtà un prepotente calo nel transito delle stesse. Come se questo non bastasse, anche la stessa Corte dei Conti francese dichiarava nel 2012 che il costo di questa nuova infrastruttura era ben più alto rispetto ai benefici raggiunti [gview file=”https://ilpoliedrico.com/wp-content/uploads/2016/03/rapport_situation_perspectives_finances_publiques_2012.pdf”]

Poi dal punto di vista ambientale ci sono i rischi ambientali legati alla natura metamorfica delle rocce in quel tratto. Uno studio del 2003 del Centro di Geotecnologie dell’Università di Siena [cite]http://www.spintadalbass.org/images/sienaamianto.pdf[/cite] ha evidenziato la presenza di minerali di amianto, che ricordo essere estremamente tossico per gli esseri umani, che andrebbero smaltiti in modo poi adeguato per non esporre tutte le comunità montane limitrofe alle polveri del minerale, con conseguente innalzamento spropositato dei costi delle operazioni di scavo 1.

| LTF (Lyon Turin Ferroviarie) ha stimato che i due tunnel principali (il tunnel di base e il tunnel di Bussoleno), le discenderie, ecc. riceveranno un flusso cumulativo di acque sotterranee compreso tra 1951 e 3973 L/s nel caso stabilizzato. Ciò equivale a una portata compresa fra i 60 e i 125 Milioni di m3 /anno, comparabile alla fornitura d’acqua necessaria a una città di circa 1 milione di abitanti. Il drenaggio delle acque sotterranee è tutt’altro che trascurabile comparativamente al ricarico totale delle acque sotterranee nelle zone situate lungo il tunnel. (Analisi degli studi condotti da LTF in merito al progetto Lione-Torino, Client : European Commission – DG-TREN [cite]http://ec.europa.eu/ten/transport/priority_projects/doc/2006-04-25/2006_ltf_final_report_it.pdf[/cite]) |

Altri sudi scientifici (anche dello stesso consorzio committente, la Lyon Turin Ferroviarie, presentato alla Commissione Europea) indicano che l’impatto ambientale sul sistema idreogeologico non sono poi così piccoli come spesso si vuole far credere da chi vuole quest’opera. È inutile girarci intorno, i motivi per dire NO a questa costosissima e inutile opera pubblica internazionale sono tanti, mentre a favore cantano solo coloro che vogliono realizzarla costi quel che costi, anche a scapito di tutti i pareri e degli studi scientifici e qualificati, che ne dimostrano la totale inutilità. Forse anche per questo il governo italiano (Monti) nel 2012 cessa di considerare prioritario il traffico merci per una versione a più basso costo della tratta internazionale, ma i costi comunque sarebbero ancora troppo alti rispetto ai dubbi vantaggi che può portare, soprattutto considerando l’investimento – a paragone molto più contenuto – dell’ammodernamento del Frejus che i tirchi francesi hanno cannato.

Ma se anche qui i motivi economici non bastano (chissà perché quando si tratta di far risparmiare denaro della collettività questi motivi non vengono mai ascoltati), ecco che spuntano inchieste della magistratura italiana che dimostrano che “… negli ultimi trent’anni l’Alta velocità è diventata uno strumento per la diffusione della corruzione e della criminalità organizzata…” [cite]http://www.repubblica.it/cronaca/2012/03/06/news/tav_saviano-31013967/[/cite] [cite]http://www.ilfattoquotidiano.it/2015/09/25/tav-aderenze-politiche-di-imprenditore-coinvolto-in-processo-per-mafia-per-lui-interventi-del-senatore-esposito/2067985/[/cite] [cite]http://video.corrieredelmezzogiorno.corriere.it/de-magistris-la-tav-imbroglio-serve-far-fare-quattrini-mafia/bf9acb26-87b3-11e5-b16f-562f60a54edb[/cite] dimostrando ancora una volta di più la mia seconda convinzione sul NO convinto al nucleare si applica esattamente anche a questo caso. Garda a volte le coincidenze!

NO-TRIV

Il caso sul prossimo referendum del 17 aprile p.v. è un vero guazzabuglio giuridico che spesso confonde gli elettori. Non entro nel merito di discutere le motivazioni storiche che hanno portato 10 regioni (in seguito 9 perché l’Abruzzo, fino ad allora in prima fila per la battaglia referendaria poi improvvisamente si è ritirato) a chiedere il referendum nazionale perché riguardano anche lo spirito politico personale di ognuno di voi e di me e io non voglio influenzare nessuno facendo una sterile campagna politica.

Nonostante vi siano molti siti internet che spiegano le ragioni del dire SI e del NO, una valutazione scientifica ed economica sono necessarie per decidere cosa scegliere di votare.

Questo è il testo del quesito referendario:

Volete voi che sia abrogato l’art. 6, comma 17, terzo periodo, del decreto legislativo 3 aprile 2006, n. 152, ‘Norme in materia ambientale’, come sostituito dal comma 239 dell’art. 1 della legge 28 dicembre 2015, n. 208 ‘Disposizioni per la formazione del bilancio annuale e pluriennale dello Stato (Legge di Stabilità 2016)’, limitatamente alle seguenti parole: “per la durata di vita utile del giacimento, nel rispetto degli standard di sicurezza e di salvaguardia ambientale”?

Ora andarsi a leggere tutto il decreto e le sue successive modifiche è una fatica immane che mi sento di risparmiarvi, dico solo che il bizantinismo delle leggi italiane è qualcosa di unico fatto apposta perché le persone normali non possano interpretarlo, un po’ come la supercazzola del Conte Mascetti nell’ottimo film “Amici miei“; uguale.

Questo è il quadro normativo che uscirebbe in caso di vittoria del SI 2, in neretto barrato le parti che verrebbero cancellate:

«17. Ai fini di tutela dell’ambiente e dell’ecosistema, all’interno del perimetro delle aree marine e costiere a qualsiasi titolo protette per scopi di tutela ambientale, in virtù di leggi nazionali, regionali o in attuazione di atti e convenzioni internazionali sono vietate le attività di ricerca, di prospezione nonché di coltivazione di idrocarburi liquidi e gassosi in mare, di cui agli articoli 4, 6 e 9 della legge 9 gennaio 1991, n. 9. Il divieto è altresì stabilito nelle zone di mare poste entro dodici miglia dalle linee di costa lungo l’intero perimetro costiero nazionale e dal perimetro esterno delle suddette aree marine e costiere protette, fatti salvi i procedimenti concessori di cui agli articoli 4, 6 e 9 della legge n. 9 del 1991 in corso alla data di entrata in vigore del decreto legislativo 29 giugno 2010, n. 128 ed i procedimenti autorizzatori e concessori conseguenti e connessi, nonché l’efficacia dei titoli abilitativi già rilasciati alla medesima data, anche ai fini della esecuzione delle attività di ricerca, sviluppo e coltivazione da autorizzare nell’ambito dei titoli stessi, delle eventuali relative proroghe e dei procedimenti autorizzatori e concessori conseguenti e connessi. Il divieto è altresì stabilito nelle zone di mare poste entro dodici miglia dalle linee di costa lungo l’intero perimetro costiero nazionale e dal perimetro esterno delle suddette aree marine e costiere protette. I titoli abilitativi già rilasciati sono fatti salvi per la durata di vita utile del giacimento, nel rispetto degli standard di sicurezza e di salvaguardia ambientale. Sono sempre assicurate le attività di manutenzione finalizzate all’adeguamento tecnologico necessario alla sicurezza degli impianti e alla tutela dell’ambiente, nonché le operazioni finali di ripristino ambientale. A decorrere dalla data di entrata in vigore della presente disposizione, i titolari delle concessioni di coltivazione in mare sono tenuti a corrispondere annualmente l’aliquota di prodotto di cui all’articolo 19, comma 1 del decreto legislativo 25 novembre 1996, n. 625, elevata dal 7% al 10% per il gas e dal 4% al 7% per l’olio. Il titolare unico o contitolare di ciascuna concessione è tenuto a versare le somme corrispondenti al valore dell’incremento dell’aliquota ad apposito capitolo dell’entrata del bilancio dello Stato, per essere interamente riassegnate, in parti uguali, ad appositi capitoli istituiti nello stato di previsione , rispettivamente, del Ministero dello sviluppo economico, per lo svolgimento delle attività di vigilanza e controllo della sicurezza anche ambientale degli impianti di ricerca e coltivazione in mare, e del Ministero dell’ambiente e della tutela del territorio e del mare, per assicurare il pieno svolgimento delle azioni di monitoraggio, ivi compresi gli adempimenti connessi alle valutazioni ambientali in ambito costiero e marino, anche mediante l’impiego dell’Istituto superiore per la protezione e la ricerca ambientale (ISPRA), delle Agenzie regionali per l’ambiente e delle strutture tecniche dei corpi dello Stato preposti alla vigilanza ambientale, e di contrasto dell’inquinamento marino.»

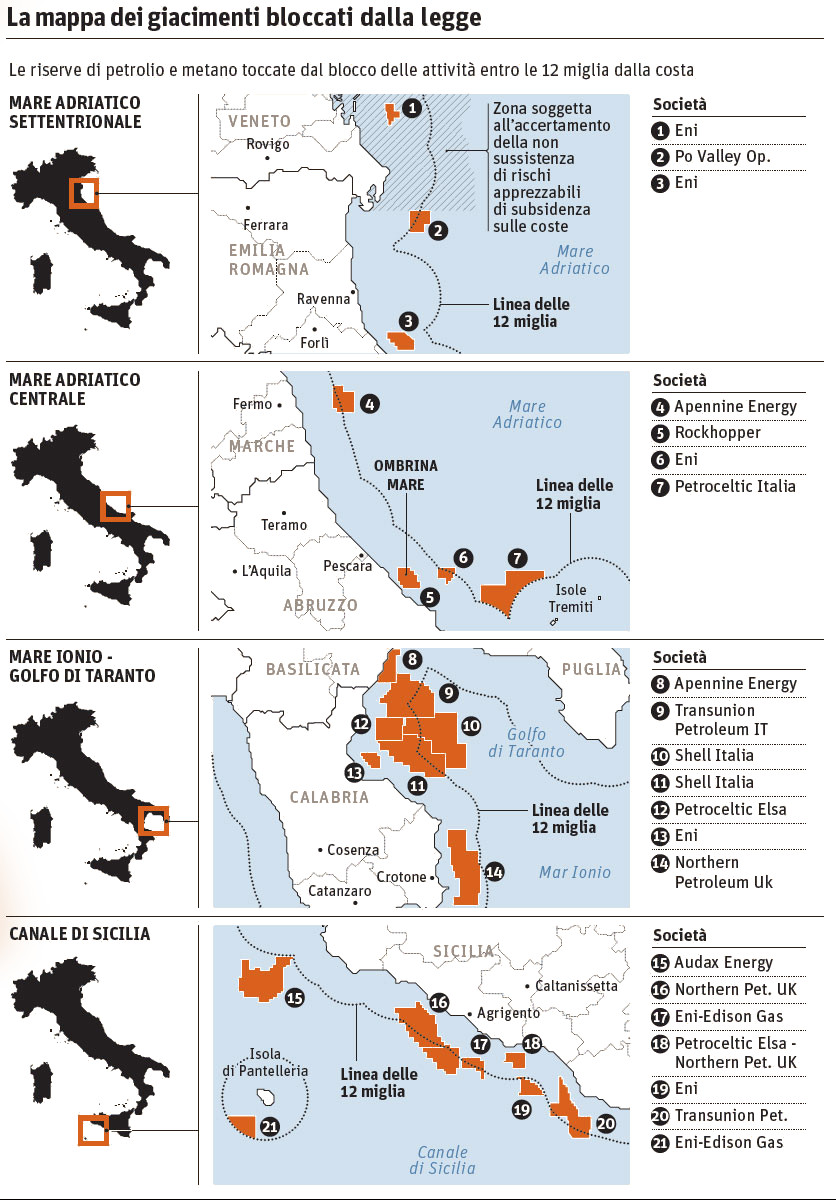

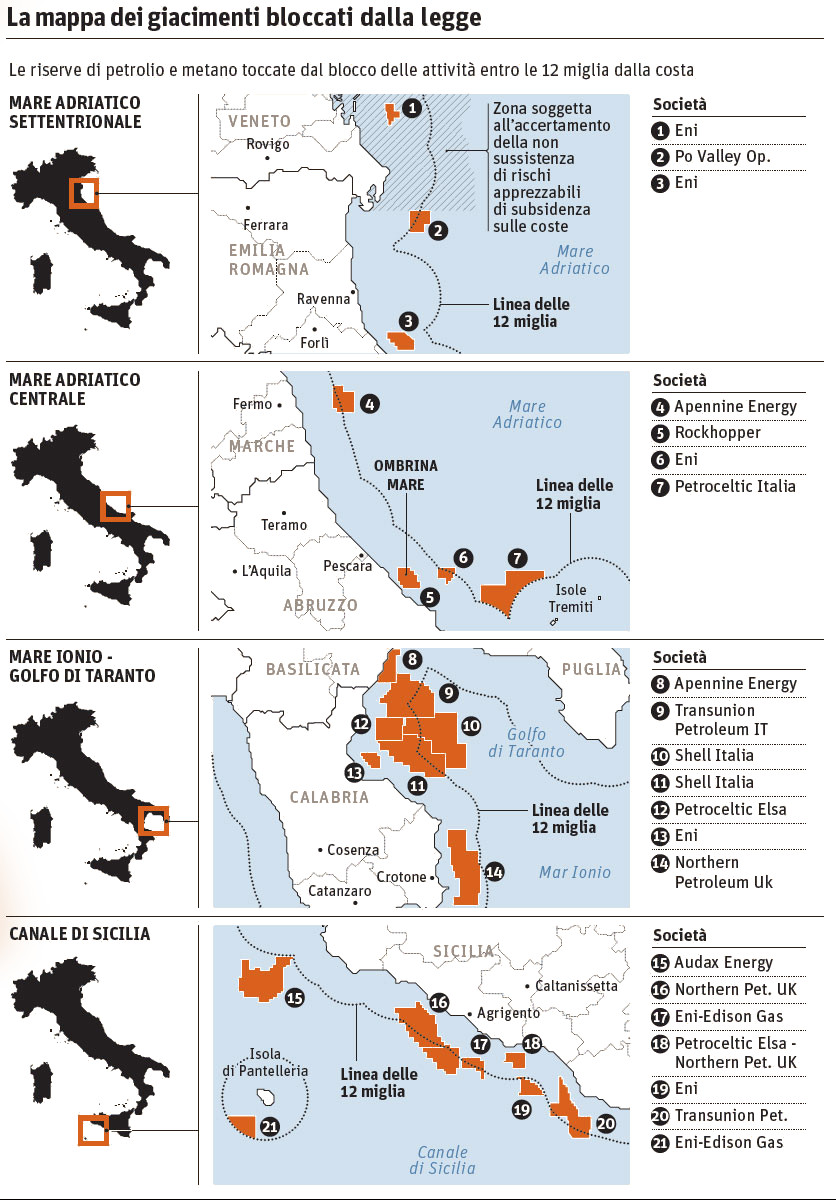

Credit: il Sole 24 Ore

Questo significa che ai pozzi estrattivi entro le 12 miglia marine, principalmente il giacimento di Guendalina (Eni) nel Medio Adriatico, il giacimento Rospo (Edison) davanti all’Abruzzo e il giacimento Vega (Edison) al largo di Ragusa, debbano cessare le estrazioni al termine della durata di concessione. Sul Sole 24 Ore del 22 febbraio scorso si suggerisce che gli altri sono troppo vecchi e quasi completamente esauriti per essere interessanti o non rientrano nello spettro delle dodici miglia dalla costa: oppure no?

Ora possiamo leggere dal suddetto articolo di legge (quello toccato dal referendum) che ogni attività di ricerca, di prospezione nonché di coltivazione 3 di idrocarburi non siano comunque consentite entro le 12 miglia marine, ma prevede anche però per le concessioni già esistenti la prosecuzione delle suddette attività per tutta la loro durata temporale. La vecchia disciplina italiana (normata dalla legge n. 9 del 1991 e n. 152 del 2006) prevedeva concessioni della durata trentennale, prorogabili per tre volte: la prima proroga sarebbe stata di dieci anni le altre due di cinque. Scaduti i 50 anni complessivi, le aziende avevano la possibilità di proseguire le trivellazioni, previa richiesta, fino all’esaurimento del giacimento senza però svolgere altre ricerche. Con la modifica imposta nella Legge di Stabilità del 2015 si è voluto estendere tutta la durata delle concessioni fino all’esaurimento dei giacimenti ma, siccome il diavolo è spesso nei dettagli, questo garantisce anche la possibilità di fare nuove ricerche, prospezioni e estrarre da nuovi pozzi accanto a quelli già esauriti con la stessa concessione!

Di fatto la situazione legislativa attuale tornerebbe ad ad essere quella prevista dalle leggi del 1991 e 2006; basta. Torneranno a non essere possibili nuove ricerche, prospezioni ed estrazioni entro le dodici miglia marine per coloro che attualmente detengono una concessione entro questo limite da sfruttare, che invece in caso di vittoria del fronte del NO o di non raggiungimento del quorum sarebbero trasformate de facto in concessioni a tempo quasi indeterminato col diritto di ricerca e sfruttamento in perpetuo.

Un’argomento che ricorre spesso – a sproposito secondo me – al fronte del NO è che così in caso di vittoria del SI l’Italia rinuncerebbe a 126 milioni di tonnellate equivalenti di petrolio accertate a fronte di 58 milioni di tonnellate equivalenti di consumo complessivo. Questo equivarrebbe al fabbisogno energetico di appena due anni (25 mesi appena!). Attualmente però solo il 7% del fabbisogno energetico italiano di origine fossile viene estratto nel territorio italiano. Solo appena qualche mese fa (12 dicembre 2015) e solo pochi giorni prima della pessima trovata nella Legge di Stabilità (28 dicembre) il governo italiano aveva firmato l’Accordo Internazionale sul Clima (Conferenza di Parigi) COP 21; in più, accordi interni all’Unione Europea (Accordo Europeo 2020) impegnano il nostro Paese a ridurre le emissioni di gas serra del 20% rispetto al 1990, a raggiungere entro tale scadenza il 20% (almeno) del fabbisogno energetico nazionale da fonti rinnovabili (e non coi trucchetti delle equiparate del CIP 6 che consentono di bruciare le peggio schifezze dei residuati petroliferi e la spazzatura!) e un aumento sempre del 20% almeno dell’efficienza energetica. Invece con la vittoria del NO o con il mancato raggiungimento del quorum si sta perseguendo una strada pericolosa e in netta controtendenza con le raccomandazioni e gli impegni presi dall’Italia in sede internazionale.

Molte altre sciocchezze poi sono state dette dal fronte del NO che non sto a ricordarle e ribatterle tutte; già ora ho scritto tantissimo e ho molte altre cose da dire (o sassolini da togliermi dalla scarpa).

Il bastian contrario

La strategia europea 2020 prevede che entro il 2020 si aumenti almeno del 20% l’efficienza energetica rispetto al 1990. Da come è illuminata la Penisola Italiana vista di notte dallo spazio direi che in realtà c’è ancora molto da lavorare sul fronte dell’efficientamento.

Nei giorni scorsi il direttore di una nota rivista scientifica accomunava i NO a tutto, NO-NUKE, NO-TRIV (i SI al prossimo referendum), NO-EOLICO, NO-OGM e così via agli antivaccinisti, agli anti pesticidi e così via cantando, salvo poi giustificare poche ore dopo il suo strambo ragionamento affermando che “non esiste un pasto gratis“. È vero non esistono pasti gratis, soprattutto quando dovremmo cercare di preservare senza stravolgere inquinare e distruggere quello che abbiamo e che dovremmo preservare per le generazioni future.

Io trovo che sia demenziale distruggere un bosco, un campo o un prato per piazzarci supra centinaia di metri quadrati di pannelli solari, quando gli stessi potrebbero essere integrati ben più produttivamente sui tetti delle case e dei fabbricati industriali e rivedere in concreto il paradigma della produzione centralizzata di energia.

Trovo demenziale devastare i fianchi delle montagne per le centrali geotermiche (vedi il caso Amiata) a grande entalpia quando sarebbe ben più produttivo, ecologico e sicuro (anche come impatto ambientale e paesaggistico) costruire le nuove strutture, e adattare quelle più vecchie, allo sfruttamento del geotermico a bassa entalpia che si può usare anche in zone non geotermicamente sensibili (a Follonica (GR) esiste dal 2011 un quartiere dove le abitazioni sono virtualmente a costo zero per l’energia consumata).

Trovo addirittura idiota rendere l’intera penisola uno spazioporto per gli assai improbabili alieni con tutta quella luce improduttiva rivolta contro il cielo; da astrofilo e uomo di scienza la trovo un insulto all’intelligenza e da italiano come un furto alle mie tasche.

Invece di volere sventrare montagne come in Val di Susa, di voler costruire improbabili centrali elettronucleari che richiedono molta acqua per funzionare (le facciamo sul PO, l’Arno o il Tevere?) e la cui produzione di energia non è né semplice – tutte le riserve mondiali di uranio e torio coprono appena un arco temporale di 50-100 anni e sono tutte in mano straniera – e né facile da modulare (quella notturna i cari cugini d’oltralpe sono costretti a svenderla quasi sottocosto, altro che pasto gratis!), distruggere la fauna ittica (e così anche la nostra industria ittica e tutto il suo indotto di centinaia di migliaia di famiglie 4 ) entro le nostre 12 miglia per qualche bicchiere di maleodorante bitume o una sniffata di metano (come gas serra il metano è ben più pericoloso – 23 volte – dell’anidride carbonica tanto che gli allevatori neozelandesi pagano 60 centesimi l’anno per ogni bovino e ben 8 euro per ogni pecora), non crede caro direttore che sia giunta l’ora di mettersi a investire sul serio (di buzzo bono come diciamo a Siena) su soluzioni concrete al problema energetico italiano con un piano di riconversione serio che escluda – per principio – l’uso di energia fossile se non come soluzione temporanea d’emergenza?

Altri paesi si stanno ingegnando per raggiungere la piena autosufficienza energetica puntando tutto sulle risorse rinnovabili; perché non dovremmo fare altrettanto noi? La porta di questo blog sarà sempre aperta ad una sua risposta.

ps. Io, mia moglie e i miei due figli siamo tutti vaccinati, mangiamo pasta di frumento Creso e sfruttiamo l’energia solare termodinamica per lavarci tutto l’anno.

pps. Io possiedo e uso un’ottima auto ibrida …

Note:

Da diverso tempo si sono sostituite le scariche elettriche dei fulmini e delle radiazioni ultraviolette delle teorie di Haldane e di Oparin con fonti energetiche più dolci e continue come le bocche idrotermali oceaniche. Lì metalli come ferro, zinco, zolfo disciolti in un ambiente acquatico ricco di energia non ionizzante, avrebbero avuto modo da fungere da catalizzatori per la creazione di molecole organiche complesse prebiotiche e, in seguito, per la vita. Le ricerche di laboratorio però mostrano che anche i luoghi di impatto cometario possono essere stati luoghi altrettanto interessanti.

Da diverso tempo si sono sostituite le scariche elettriche dei fulmini e delle radiazioni ultraviolette delle teorie di Haldane e di Oparin con fonti energetiche più dolci e continue come le bocche idrotermali oceaniche. Lì metalli come ferro, zinco, zolfo disciolti in un ambiente acquatico ricco di energia non ionizzante, avrebbero avuto modo da fungere da catalizzatori per la creazione di molecole organiche complesse prebiotiche e, in seguito, per la vita. Le ricerche di laboratorio però mostrano che anche i luoghi di impatto cometario possono essere stati luoghi altrettanto interessanti.