[latexpage]

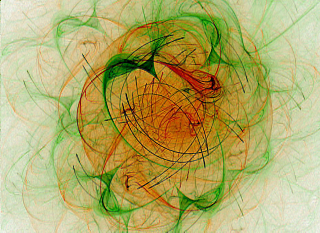

Una coppia di neutralini si annichila e decade in una pioggia di normali particelle elementari.

Credit: Il Poliedrico

All’interno del Modello Cosmologico Standard, la Teoria della Nucleosintesi Primordiale descrive esattamente la composizione [cite]http://www.einstein-online.info/spotlights/BBN[/cite] della materia presente nell’Universo e indica che l’84,54% di questa è di natura non barionica, cioè non è composta da leptoni e quark ma da una forma di materia totalmente sconosciuta che non possiede alcuna carica elettromagnetica o di colore chiamata WIMP (Weakly Interacting Massive Particle). Questa è una classe di nuove e ipotetiche particelle con una massa compresa tra poche decine e un migliaio di $GeV/c^2$ (un $GeV/c^2$ è circa la massa di un atomo di idrogeno). L’esistenza di queste particelle è stata proposta per risolvere il problema della materia oscura teorizzata dal Modello Cosmologico Standard. L’esistenza delle WIMP non è stata ancora provata con certezza, però alcune delle caratteristiche fondamentali che queste particelle dovrebbero possedere indicano in quale direzione cercare.

L’esistenza stessa delle strutture a piccola scala come le galassie e gli ammassi di galassie esclude che da una fase inizialmente isotropa come quella descritta dalla radiazione cosmica di fondo queste si siano potute evolvere; la presenza di massicce quantità di materia oscura calda ($v >95\% c$) avrebbe finito invece per dissolverle. Per questo, non escludendone a priori l’esistenza 1, l’esistenza di una sola forma di materia oscura calda è dubbia. A questo punto non resta che ipotizzare una forma di materia oscura che si muove a velocità non relativistiche, fino all’1 per cento di quella della luce.

Il problema nasce con il Modello Standard che non prevede altre forme di materia se non quelle finora conosciute. Per ovviare a questo inconveniente e ad altri problemi irrisolti dal Modello Standard 2 sono state elaborate dozzine di teorie alternative dette Beyond the Standard Model (BSM, ovvero oltre il Modello Standard) che propongono soluzioni – almeno in parte – i problemi menzionati nella nota e a quello oggetto di questo articolo.

Un po’ tutte le BSM introducono nuove particelle, una di queste è la Supersimmetria. La Supersimmetria introduce una nuova classe di particelle chiamate superpartner all’interno del classico Modello Standard. Nonostante che il tentativo di identificare questi nuovi partner supersimmetrici – sparticelle – sia per ora fallito, le BSM riescono agevolmente a risolvere i problemi che il Modello Standard non è mai riuscito a superare.

Secondo queste teorie, i fermioni, che costituiscono la materia, hanno come superpartner altrettanti bosoni che trasmettono le forze, mentre i bosoni conosciuti hanno i loro fermioni superpartner. Poiché le particelle e le loro superpartner sono di tipo opposto, il loro contributo energetico al campo di Higgs si annulla.

Dalla tabella qui accanto si nota come per ogni bosone di gauge si ha un superpartner detto gaugino, mentre per il gravitone esiste il gravitino. Il problema essenziale è nella massa di questi superpartner che, almeno in teoria, dovrebbe essere la stessa delle altre particelle normali corrispondenti. In realtà non pare così. Finora nessuno di questi partner supersimmmetrici è stato ancora mai rilevato, tant’è che è stato supposto che anche per le superparticelle sia accaduto un fenomeno di rottura di simmetria, portando di fatto ad avere dei partner supersimmetrici molto più massicci dei loro corrispondenti di quanto ci si aspettasse, oltre il migliaio di $GeV$.

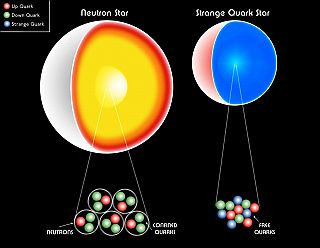

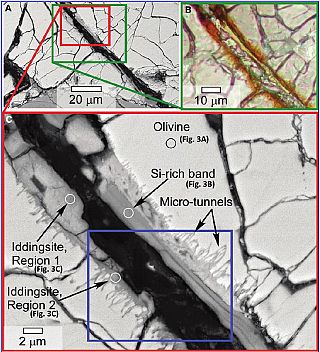

I più promettenti candidati della materia oscura fredda sono quindi i più leggeri superpartners indicati dalle BSM. Escludendo i superpartners degli elettroni e dei quark che anch’essi dispongono di carica elettrica e di colore, rimangono disponibili lo zino (il superpartner fermionico del bosone Z), il fotino e l’higgsino, tutti altrettanti fermioni 3. Queste sparticelle in sé non sono rilevabili, interagiscono solo con l’interazione debole e la gravità ma possono legarsi tra loro formando una particella esotica molto particolare: il neutralino. In quanto miscela quantistica di diverse altre sparticelle, ne possono esistere fino a 4 tipi diversi di neutralini, tutti fermioni di Majorana e senza alcun tipo di carica, il più leggero dei quali è in genere ritenuto stabile. Il fatto che i neutralini siano fermioni di Majorana è molto importante, perché dà in qualche modo la chiave per rilevarli, se esistono. Essendo sia particelle che antiparticelle di loro stessi, esiste la possibilità che due diversi neutralini dello stesso tipo si scontrino e si annichilino di conseguenza. Il risultato è una pioggia di radiazione gamma e di altre particelle elementari come sottoprodotti, esattamente come avviene per le particelle conosciute quando si scontrano con le loro rispettive antiparticelle [cite]http://arxiv.org/abs/0806.2214[/cite].

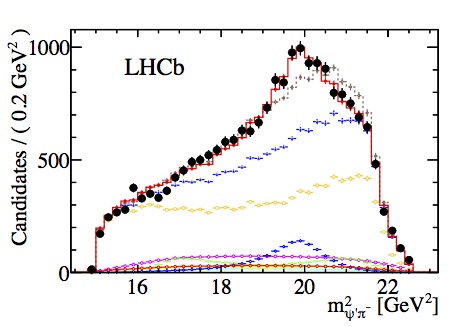

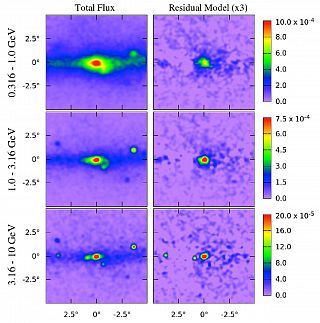

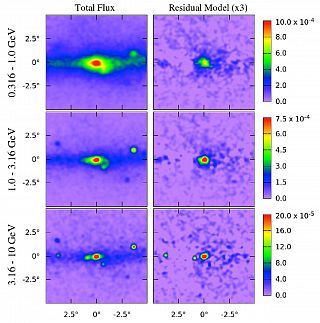

Le mappe a raggi gamma prima (a sinistra) e le mappe a cui è stato sottratto il piano galattico (a destra), in unità di fotoni/cm2/s/sr.

Le immagini sulla destra mostrano un significativo eccesso centrale e spazialmente esteso, con un picco a ~ 1-3 GeV. I risultati sono mostrati in coordinate galattiche, e tutte le mappe sono state levigate da una gaussiana di 0,25°.

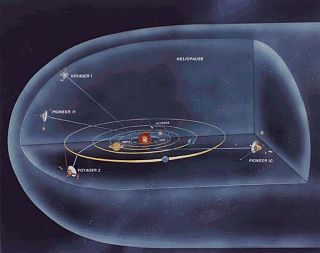

E dove cercare la materia oscura, questi neutralini che ne sono soltanto un aspetto di un panorama ben più ampio? Se la materia oscura è davvero sensibile alla gravità, perché non cercarla dove la gravità è più accentuata, ovvero nei pressi dei nuclei galattici e nelle stelle? Nei pressi dei buchi neri centrali i neutralini sarebbero costretti a muoversi piuttosto rapidamente sotto l’influenza gravitazionale, e quindi anche a collidere e annichilirsi con una certa facilità. Il risultato delle annichilazioni e del loro decadimento successivo dovrebbe essere così rilevabile.

Appunto questo è stato fatto, studiando i dati che in 5 anni di attività il Fermi Gamma-ray Space Telescope ha prodotto. Un gruppo di scienziati coordinato da Dan Hooper ed altri, ha esaminando i dati forniti dal satellite riguardanti il centro della nostra galassia e creato una mappa ad alta risoluzione che si estende per 5000 anni luce dal centro della galassia nel regno dei raggi gamma [cite]http://arxiv.org/abs/1402.6703[/cite] [cite]http://arxiv.org/abs/0910.2998[/cite].

Una volta eliminato il segnale spurio prodotto da altri fenomeni naturali conosciuti, come ad esempio le pulsar millisecondo nei pressi del centro galattico, il risultato (visibile nei riquadri di destra dell’immagine qui accanto) è interessante. Qui risalta un segnale attorno ai 31-40 $GeV$ che gli autori dello studio attribuiscono all’annichilazione di materia oscura e dei suoi sottoprocessi di decadimento per una densità di materia oscura nei pressi del centro galattico stimata attorno ai 0,3 $GeV/cm^3$.

Le dimensioni di questa bolla di materia oscura non sono note, i dati di questo studio dimostrano che fino a 5000 anni luce la distribuzione angolare della materia oscura è sferica e centrata sul centro dinamico della Via Lattea (entro ~ 0,05° da Sgr A*), senza mostrare alcun andamento preferenziale rispetto al piano galattico o la sua perpendicolare.

Questo dato non è poi lontano da quello estrapolato da Lisa Randall e Matthew Reece dell’Università di Harvard, che sostengono di aver calcolato le dimensioni e la densità di un disco di materia oscura che permea la Via Lattea [cite]http://arxiv.org/abs/1403.0576[/cite] attraverso lo studio delle periodiche estinzioni di massa avvenute sulla Terra e le tracce di impatto di meteoriti di grandi dimensioni sul nostro pianeta 4. Questo disco avrebbe un raggio di circa 10000 anni luce e una densità di una massa solare per anno luce cubico.

A questo punto potrà essere il satellite Gaia, che mappando il campo gravitazionale della Galassia, potrà accertare o meno l’esistenza di questo o di un altro disco che permea la Via Lattea.

Il lavoro del gruppo di Hooper, che per ora è solo un pre-print, è piuttosto incoraggiante nella sua tesi. Se venisse confermato, o nei dati o da altre osservazioni su altre galassie, potrebbe essere la conferma dell’esistenza della materia oscura non barionica fredda che da anni è stata ipotizzata e finora mai confermata. Intanto, altri lavori [cite]http://arxiv.org/abs/1402.2301[/cite] indicano una debole emissione nei raggi X in altre galassie proprio dove ci si aspetta di trovare le traccie dovute al decadimento del neutrino sterile, un’altra ipotetica particella non prevista dal Modello Standard.

La fine di questo modello? Non credo, semmai sarebbe più corretto parlare di un suo superamento da parte delle BSM. Così come la Meccanica Newtoniana si dimostra comunque valida fino a velocità non relativistiche, e nessuno penserebbe di sostituirla con la Relatività Generale per calcolare ad esempio l’orbita di una cometa, Il Modello Standard rimarrà valido fino a quando non sarà stata scritta una Teoria del Tutto elegante e altrettanto funzionante.

Note: