Francamente ancora non sappiamo se esista o meno il Bosone di Higgs, il famoso bosone portatore di massa delle particelle, quello che nel titolo di un suo libro 1 il fisico Leon Max Lederman aveva chiamato “maledetta particella” (goddnam particle) e che un editore un po’ troppo moralista trovandola sconveniente la cambiò in “Particella di Dio”. Adesso un paio di recenti esperimenti pongono limiti alla sua esistenza. Un po’ come dire “ non lo abbiamo ancora beccato, ma ci sono indizi che ci fanno credere che sia rinchiuso in quella stanza”.

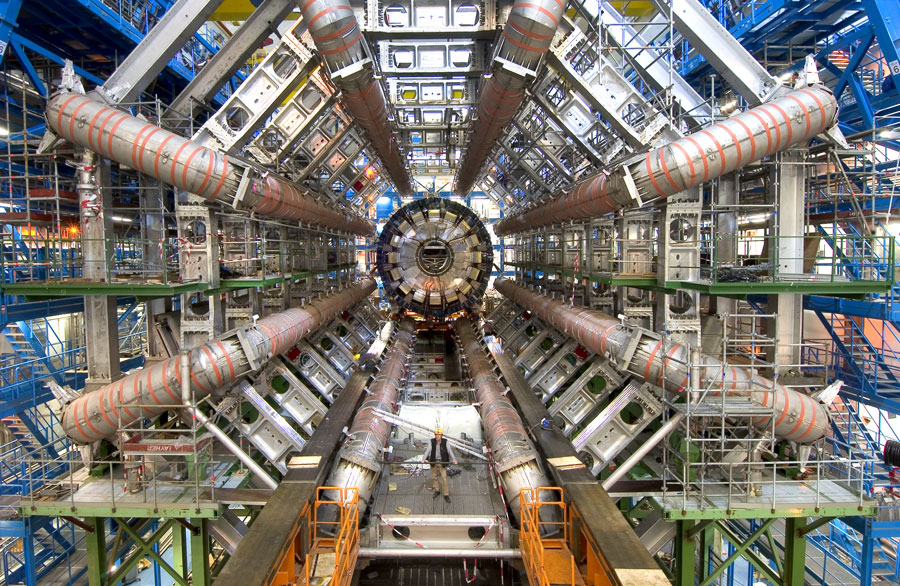

In una conferenza stampa il 13 dicembre i ricercatori del CERN di Ginevra hanno annunciato che due diversi esperimenti 2 in corso presso il più grande acceleratore di particelle del mondo, il Large Hadron Collider (LHC) hanno posto limiti ben ristretti alle finestre energetiche in cui può essere verificata l’esistenza del bosone di Higgs.

Ma che cosa sarebbe esattamente il bosone di Higgs 3 ?

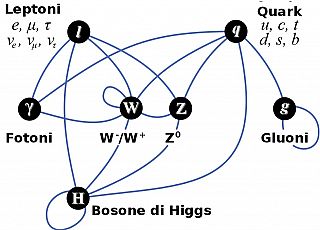

Il Modello Standard – che è l’evoluzione estrema della Meccanica Quantistica – descrive le basi di come le particelle elementari (fermioni e leptoni) interagiscono fra loro tramite bosoni di gauge, ovvero particelle che mediano, trasportano tre delle quattro forze fondamentali della natura:

Il Modello Standard – che è l’evoluzione estrema della Meccanica Quantistica – descrive le basi di come le particelle elementari (fermioni e leptoni) interagiscono fra loro tramite bosoni di gauge, ovvero particelle che mediano, trasportano tre delle quattro forze fondamentali della natura:

- la forza elettromagnetica (luce, magnetismo, elettricità) è mediata dai fotoni;

- la forza nucleare forte (la forza che tiene uniti i quark per formare gli adroni – protoni e neutroni) è mediata dai gluoni;

- la forza nucleare debole (responsabile del decadimento radioattivo beta – decadimento del neutrone in protone) mediata dai bosoni W, Z e appunto il famoso bosone di Higgs.

La particolare natura della forza debole di interagire 4 sia con i leptoni che con i fermioni, sia con particelle cariche che particelle neutre, richiede appunto tre bosoni distinti per agire: uno per le interazioni cariche (W), uno per le interazioni neutre (Z) e uno (Higgs) per dare la massa a tutte le altre particelle, tranne i fotoni e i gluoni.

L’unica forza fondamentale che per ora rimane esclusa dal Modello Standard è la forza di gravità che verrebbe mediata a sua volta dal suo bosone: il gravitone.

Come funzionerebbe il bosone di Higgs?

Il bosone di Higgs fu teorizzato attorno al 1960 dal fisico Peter Higgs, ed altri, per spiegare il modo in cui le particelle elementari acquistano massa a riposo.

Non è facile spiegare come questo avvenga senza ricorrere alla matematica, ma un fisico dell’University College di Londra, David Miller raccolse la sfida del ministro britannico della scienza, William Waldegrave che aveva indetto in proposito un concorso, in palio una bottiglia di champagne.

L’immagine suggerita da David Miller 5 è quella di un salone (lo spazio) pieno di persone (il campo di Higgs) che sono distribuite in maniera uniforme e impegnate a conversare ciascuna con il proprio vicino. All’improvviso questa festa viene animata dall’arrivo di un personaggio famoso (una particella) che attraversa la stanza. Tutte le persone vicine sono attratte da lui (la rottura di simmetria) e vi si affollano intorno. Man mano che il personaggio famoso si muove nella sala attrae altre persone a lui più vicine mentre quelle che lascia alle sue spalle tornano nella loro posizione originale. A causa di questo affollamento aumenta la resistenza al movimento, in altre parole il personaggio famoso-particella acquista la sua massa.

Per spiegare invece il concetto di bosone di Higgs, sempre Miller suggerisce di immaginare che all’improvviso, nello stesso salone pieno di gente, qualcuno faccia circolare una voce. Le persone più vicine la ascoltano per primi e si riuniscono per apprendere qualche dettaglio in più, quindi si voltano e si avvicinano alle altre persone nei paraggi per riferire quanto ascoltato. In questo modo la stanza viene attraversata da un’ondata di capannelli che si formano man mano e che a loro volta, come il precedente personaggio famoso, acquisiscono massa. Il bosone di Higgs sarebbe appunto questa rottura di simmetria nel campo di Higgs.

Nelle tre dimensioni, e con tutte le complicazioni relativistiche del caso, questo è in pratica il meccanismo postulato da Higgs. Al fine di dare alle particelle una massa, il vuoto si distorce a livello locale ogni volta che una particella si muove attraverso di esso provocando una rottura di simmetria. La distorsione – il raggruppamento del campo di Higgs intorno alla particella – genera la massa.

L’idea arriva direttamente dalla fisica dei solidi. Invece di un campo diffuso in tutto lo spazio, un solido contiene un reticolo cristallino di atomi con carica positiva. Quando un elettrone si muove attraverso il reticolo attrae gli atomi, causando un aumento di massa effettiva dell’elettrone fino a 40 volte più grande della massa di un elettrone libero.

A questo punto Il campo di Higgs postulato è una sorta di reticolo ipotetico nel vuoto che riempie il nostro Universo. Così si può spiegare perché le particelle Z e W che trasportano le interazioni deboli sono così pesanti, mentre il fotone che trasporta le forze elettromagnetiche sia senza massa. Ed è grazie a questa rottura di simmetria del vuoto che le particelle cominciano a interagire fra loro, acquisiscono massa e non possono viaggiare più veloci della luce.

Ma le analogie con la fisica dei solidi non finiscono qui: in un reticolo cristallino ci possono essere alterazioni locali che si muovono al suo interno senza il bisogno del transito di un elettrone che attrae gli atomi. Queste onde possono comportarsi esattamente come se fossero particelle. Queste sono chiamati fononi e anche loro sono bosoni.

Tuttavia, il Modello Standard può spiegare solo il 4% della materia e dell’energia contenute nell’universo.

Si presume che il resto sia fatto di materia oscura (23%) e l’energia oscura (73%). Questo significa che gli atomi costituiscono solo una netta minoranza di questo universo mentre il 96% ancora non è compreso nel Modello Standard, come non lo è del resto la gravitazione, la forza più diffusa nell’universo.

Nonostante i suoi successi predittivi, l’attuale Modello Standard è una delle più brutte teorie proposte dalla fisica moderna.

Ha più di 19 parametri liberi, 3 serie di particelle ridondanti, 36 diversi tipi di quark e anti-quark, e una variegata collezione di gluoni, leptoni, bosoni, particelle di Higgs, particelle di Yang-Mills, etc.

Questo indica – e sono anche i suoi ideatori ad ammetterlo – che il Modello Standard non è certamente la teoria finale.

Al momento, l’unica teoria matematicamente auto-consistente in grado di fornire un quadro realmente unificato dell’universo è la teoria delle stringhe.

Questa Super Teoria del Tutto non è ancora stata verificata, ma il Large Hadron Collider può finalmente trovare prove convincenti a favore di questa promettente teoria.

Il prossimo obiettivo per l’LHC potrebbe essere quindi individuare la materia oscura, quella sostanza invisibile che impedisce alle galassie di dissolversi.

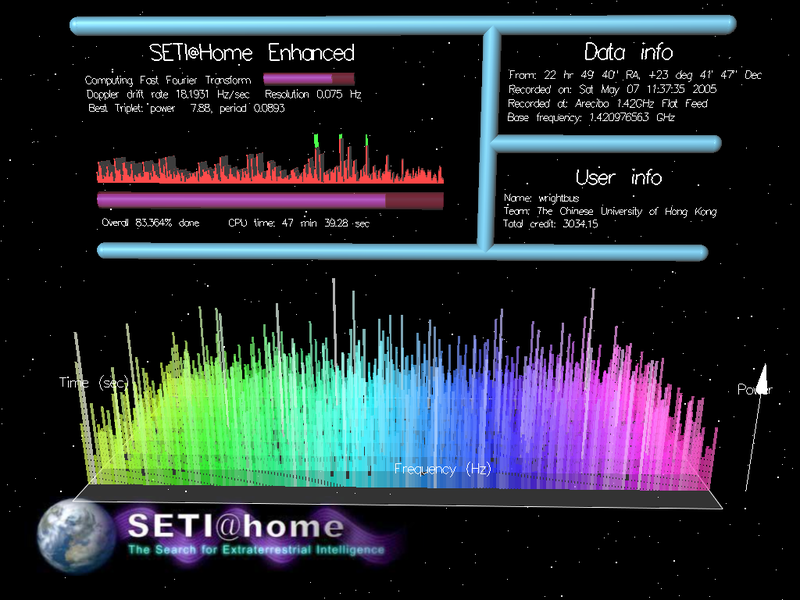

Le osservazioni dei prossimi due anni consentiranno l’esplorazione sistematica dei pianeti scoperti di Kepler nella finestra delle microonde da 1-10 GHz. L’ATA è l’unico radiotelescopio che può fornire l’accesso immediato a decine di milioni di canali in qualsiasi momento e ovunque in questa fascia di ben 9 miliardi di canali (ogni canale è largo appena un 1 Hz!).

Le osservazioni dei prossimi due anni consentiranno l’esplorazione sistematica dei pianeti scoperti di Kepler nella finestra delle microonde da 1-10 GHz. L’ATA è l’unico radiotelescopio che può fornire l’accesso immediato a decine di milioni di canali in qualsiasi momento e ovunque in questa fascia di ben 9 miliardi di canali (ogni canale è largo appena un 1 Hz!).

dove

dove