Il ruolo del mantello nei pianeti rocciosi viene spesso sottovalutato. Adesso è giunto il momento di riconsiderare la loro importanza nello sviluppo di un pianeta.

Si suppone che i mantelli dei pianeti rocciosi siano, come ci mostra la composizione chimica di quello terrestre, ricchi di magnesio e ossigeno. Quindi studiare i minerali di ossido di magnesio può essere utile per capire l’interno dei pianeti.

Si suppone che i mantelli dei pianeti rocciosi siano, come ci mostra la composizione chimica di quello terrestre, ricchi di magnesio e ossigeno. Quindi studiare i minerali di ossido di magnesio può essere utile per capire l’interno dei pianeti.

Un team guidato da Stewart McWilliams del Carnegie Institute of Science è riuscito a riprodurre le proibitive condizioni esistenti nei mantelli planetari, ovvero pressioni che vanno da 0,3 TPa 1, il doppio della pressione esistente nella zona del mantello inferiore terrestre, fino a 1,4 TPa, condizione questa presente su pianeti molto più grandi della Terra che continuamente oggi scopriamo in orbita ad altre stelle.

Il metodo usato per produrre simili pressioni e temperature è simile a quello sviluppato per i reattori a fusione nuleare chiamato fusione a confinamento inerziale (Inertial confinement fusion, in breve ICF) In questo caso però il bersaglio è composto da molecole di ossido di magnesio, appunto uno dei composti più importanti del mantello.

Particolarmente resistente alle alte temperature e pressioni, l’ossido di magnesio è largarmente utilizzato nell’industria dei materiali refrattari e nei cementi per l’edilizia. Studi teorici mostrano che esso può esistere in natura solo in tre diversi stati: solido alle nostre condizioni ambientali, liquido a temperature elevate (> 3125 K a pressione normale) e un’altra particolare struttura solida che si manifesta a pressioni – e temperature – molto alte, come quelle ad esempio nel mantello di un pianeta.

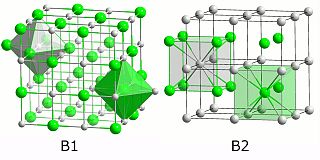

Quest’ultima struttura però finora non era mai stata osservata prima. McWilliams e il suo team hanno studiato per la prima volta come l’ossido di magnesio si comporta in questi diversi stati scoprendo che il legame molecolare subisce importanti modifiche passando da uno schema simile al cloruro di sodio nella prima forma (B1 nella figura) alla seconda fase solida simile a quella delle leghe metalliche binarie (B2).

Un altro particolare importante è stato osservato nell’ossido di magnesio: questo allo stato fuso – magma fuso – diventa un semiconduttore, mentre al normale stato solido è un isolante naturale. Questa scoperta riflette il comportamento alla fusione di altri non metalli come il carbonio, il silicio e lo zolfo.

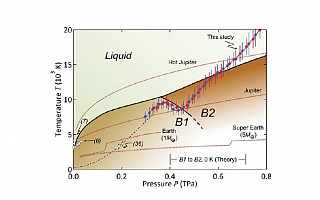

Diagramma di fase del MgO: la fase solida B1 e la fase solida B2. I pallini colorati sono i dati ricavati dagli esperimenti. In grigio l’intervallo teorico di transizione previsto dalla teoria a 0 K. Le temperature di fusione sperimentali (6, 7) sono rappresentate dai triangoli bianchi.

Sono inoltre mostrate le condizioni planetarie interne previste per la Terra, quelle ipotizzate per un pianeta di 5 masse terrestri, Giove, e per la massa di un gioviano caldo; la discontinuità nella temperatura (a 1.3 e 6.5 Mbar rispettivamente) nei pianeti di tipo terrestre corrispondono al limite del mantello.

Queste scoperte sono molto importanti e possono aiutare a capire come possono essersi evoluti i pianeti.

Prima che un pianeta si avvii verso la sua fase di differenziazione nota come Catastrofe del Ferro le condizioni fisiche – principalmente temperatura – possono permettere l’esistenza di ossido di magnesio – e di altri non metalli – allo stato fuso, un oceano di magma in grado di generare correnti elettriche e quindi un campo magnetico.

Questo campo magnetico primordiale può pertanto essere abbastanza importante da riuscire a proteggere una atmosfera primordiale generata dal degassamento del magma liquido dall’azione erosiva dei venti stellari che nelle prime fasi della nascita di un sistema solare possono essere particolarmente violenti.

In seguito il campo magnetico generato da un nucleo di ferro fuso differenziato può essere ben più efficace delle correnti elettriche di un unico grande oceano di magma in via di solidificazione e di stratificazione.

Allo stesso modo ancora adesso l’ossido di magnesio nella seconda fase solida può ancora esistere nei mantelli inferiori di esopianeti rocciosi super massicci, generando un campo magnetico che forse il nucleo solido non può generare 2.

Riferimenti:

“Phase Transformations and Metallization of Magnesium Oxide at High Pressure and Temperature,” by R.S. McWilliams et al., Science, 2012.

Published Online November 22 2012

Science 7 December 2012:

Vol. 338 no. 6112 pp. 1330-1333

DOI: 10.1126/science.1229450